1. Einleitung

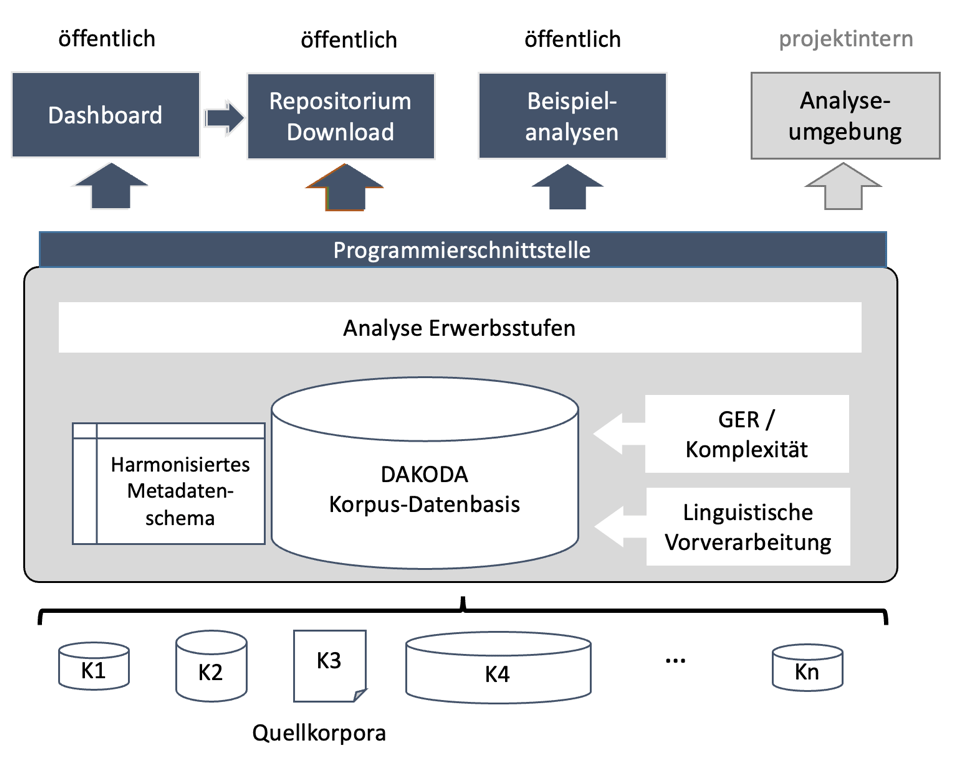

In diesem Beitrag soll das durch das BMBF geförderte Forschungsprojekt DAKODA1 vorgestellt werden. Das interdisziplinäre Vorhaben ist eine Kooperation der Fachbereiche Deutsch als Fremd- und Zweitsprache (Universität Leipzig) und Computerlinguistik (FernUniversität in Hagen). DAKODA exploriert das Potenzial sprachtechnologischer Verfahren, spezifische theoriebasierte Konstrukte der L2-Erwerbsforschung in Lernersprache automatisiert zu erfassen. Es will zudem kritisch beleuchten, inwiefern solche Verfahren dafür geeignet sind, neue Erkenntnisse zu generieren. Zentrales Projektziel ist zudem die Vermittlung entsprechender technischer Datenkompetenzen an das Fach DaF/DaZ.

Hintergrund des Projekts ist die Tatsache, dass im Fach Deutsch als Fremd- und Zweitsprache (DaF/DaZ) immer größere digitale Sammlungen geschriebener und gesprochener Lernertexte zur empirischen Analyse des Fremd- oder Zweitsprachenerwerbs (L2-Erwerb) zur Verfügung stehen, sogenannte Lernerkorpora. Trotz weiterhin bestehender Lücken in der Lernerkorpuslandschaft ist somit nunmehr eine recht breite Evidenzgrundlage gegeben. Das ist begrüßenswert, denn etliche Arbeiten zum L2-Erwerb des Deutschen beruhen auf kleinen Stichproben und/oder nicht publizierten L2-Daten und sind dann nicht replizierbar. Auch weil ihre Erstellung enorm ressourcenintensiv ist, sind Lernerkorpora im Vergleich zu L1-Korpora recht klein und werden anders als diese zwangsläufig nicht mit dem Anspruch auf Repräsentativität, sondern entlang spezifischer Forschungsfragen konstruiert. Dies führt zu einer großen Heterogenität der bestehenden Lernerkorpuslandschaft des Deutschen. Nicht nur deshalb, sondern auch weil Lernerkorpora in uneinheitlichen Formaten vorliegen, unterschiedlich tief erschlossen und über sehr verschiedene Wege zugänglich sind, sind Erwerbsstudien, die gleichzeitig auf mehrere Lernerkorpora rekurrieren, der Ausnahmefall. Solche korpusübergreifenden Ansätze sind jedoch vielversprechend; ihr Potenzial liegt zum einen im Rückgriff auf größere Datenmengen und zum anderen darin, dass etwaige variationsverursachende Einflussfaktoren sichtbar werden können (z.B. Aufgabenstellungen, Erwerbsalter usw.). Ein Ziel von DAKODA ist deshalb, eine große Zahl deutscher Lernerkorpora so miteinander zu verankern und zugänglich zu machen, dass ein korpusübergreifender Zugriff möglich ist. Dies erfordert umfangreiche Vorarbeiten. In diesem Beitrag gehen wir deshalb zunächst ausführlicher auf die Gegebenheiten und Herausforderungen der deutschen Lernerkorpuslandschaft ein (Abschnitt 2).

Große Datenmengen lassen sich kaum mehr mit manuellen Annotationsverfahren bearbeiten. Deshalb sind für die Generierung spracherwerbsbezogener Erkenntnisse sprachtechnologische Verfahren, die (teil)automatisierte Auswertungen erlauben, von zunehmender Bedeutung. Die automatisierte Analyse von Lernersprache ist jedoch viel voraussetzungs- und hürdenreicher als die Analyse anderer Sprachdaten, weil erstere häufig von zielsprachlichen Normen abweicht. Zudem liegen dazu bislang für das Deutsche nur wenige, allgemeinere Tools vor, z.B. zur Wortartenerkennung (PoS-Tagging) oder syntaktischen Analyse (Parsing). Werkzeuge, mit deren Hilfe auch genau solche sprachlichen Strukturen erfasst werden können, die im Spracherwerb eine wichtige Rolle spielen, fehlen noch. In DAKODA soll deshalb die übergeordnete Frage exploriert werden, wie genau sprachtechnologische Verfahren spezifische theoriebasierte Konstrukte der L2-Erwerbsforschung erfassen können. So sollen Möglichkeiten und Limitationen sprachtechnologischer Datenanalyseansätze für diesen Anwendungsfall herausgestellt werden.

Als Testfall dienen in DAKODA die Spracherwerbsstufen, wie sie in der Processability Theory (PT, vgl. Pienemann 1998, 2005) entwickelt wurden und in Theorie und Praxis breite Verwendung gefunden haben. Die PT geht davon aus, dass bestimmte grammatische Phänomene zwingend aufeinander aufbauend erworben werden (vgl. Abschnitt 2.3). Trotz einer robusten empirischen Evidenz für die Haltbarkeit der Annahme des stufenförmigen Erwerbs zentraler Verbstellungsmuster des Deutschen bestehen weiterhin etliche Forschungsdesiderata. Diese betreffen etwa Fragen danach, inwiefern die die Erwerbsstufen definierenden sprachlichen Merkmale (z.B. Verbendstellung in Nebensätzen) in bestimmten sprachlichen Kontexten (z.B. verschiedenen Nebensatzarten) früher oder später oder unterschiedlich produktiv auftreten, es also auch stufeninterne Erwerbsschritte gibt (vgl. dazu Bettoni / Di Biase 2015). Auch etwaige Zusammenhänge mit anderen wichtigen Konstrukten der L2-Erwerbsforschung (wie etwa der sprachlichen Komplexität) oder den Niveaustufen des Gemeinsamen europäischen Referenzrahmens (GER, vgl. Europarat 2001, 2020) sind noch nahezu unerforscht. Neuere Befunde der Erwerbsforschung zur Bedeutung von intra- und interindividueller Variation sowie zur Nichtlinearität und Instabilität von Erwerbsverläufen geben zudem zum einen Anlass zu der Vermutung, dass lernendeninterne (z.B. das Alter) oder -externe (z.B. die bearbeitete Aufgabe) Faktoren erheblichen Einfluss nehmen können. Zum anderen laden sie dazu ein, auch die produzierte Lernersprache selbst noch detaillierter in ihrem Variationsspektrum in den Fokus zu nehmen. In DAKODA sollen derartige Fragen aufbauend auf den sprachtechnologischen Analysen für vier Erwerbsstufen (vgl. Tab. 2) in der o.g. großen Datenbasis beleuchtet werden. Die Möglichkeit, derartige Untersuchungen durchzuführen, hängt davon ab, wie gut die im Projekt entwickelten bzw. genutzten automatischen Analysen funktionieren. Insofern ist DAKODA ein dezidiert exploratives und sicher nicht risikofreies Vorhaben, innerhalb dessen prozessorientierte, iterative Prüfungen der Güte der genutzten Verfahren eine entscheidende Rolle spielen.

Das Projekt wird in einer Förderlinie zur Förderung der Datenkompetenzen des wissenschaftlichen Nachwuchses des BMBF finanziert. Unseres Erachtens wird in DaF/DaZ computerlinguistischen Ansätzen oft mit Zurückhaltung begegnet, v.a. aus einer mangelnden Vertrautheit mit den entsprechenden Datenanalyseverfahren heraus. Gleichzeitig haben Fachkolleg:innen zunehmend mit großen Datenmengen zu tun. DAKODA möchte diesen Vorbehalten entgegentreten und einen Beitrag zur Förderung solcher Datenkompetenzen vor allem beim wissenschaftlichen Nachwuchs leisten. Dazu werden verschiedene, teils öffentliche Workshops durchgeführt.

Lernerkorpusarbeit ist hürdenreich und arbeitsintensiv. Sie erfordert ein komplexes Forschungsdatenmanagement, das u.E. möglichst nach Prinzipien von Open Science angegangen werden sollte. Diesbezüglich möchten wir in diesem Beitrag, aber auch mit dem Projekt insgesamt zu mehr Austausch beitragen. Außerdem ist die technische Verarbeitung von Lernersprache hochkomplex und entwickelt sich dynamisch. Mit DAKODA hoffen wir ausloten zu können, wie gut bestimmte automatisierte Verfahren über sehr heterogene Korpora funktionieren.

Dieser Beitrag schildert zunächst die Hintergründe des Projekts (Abschnitt 2) und geht dabei zum einen auf infrastrukturelle Gegebenheiten und Herausforderungen der deutschen Lernerkorpuslandschaft ein (Abschnitt 2.1-2.2), zum anderen werden die zentralen erwerbslinguistischen Konstrukte geschildert (Erwerbsstufen; sprachliche Komplexität; GER-Niveaus, Abschnitt 2.3-2.5). Die nachfolgenden Kapitel skizzieren Forschungsfragen, Datenbasis und Design des DAKODA-Projekts (Abschnitt 3-5).

2. Hintergrund

2.1 Lernerkorpora für Deutsch als L2

Lernerkorpora sind idealerweise öffentliche, systematisch erstellte, meist digitale Sammlungen gesprochener und/oder geschriebener L22-Produktionen. Die Lernerkorpuslinguistik ist eine junge Forschungsdisziplin, die sich seit den 90er Jahren aus der anglistischen Fremdsprachendidaktik heraus entwickelt und mittlerweile über eine Interessensvertretung (die Learner Corpus Association)3, ein Handbuch (Granger et al. 2015; siehe auch Tracy-Ventura / Paquot 2020) sowie eine Zeitschrift (International Journal of Learner Corpus Research) verfügt. Sie ist vor allem international rege, im deutschsprachigen Raum demgegenüber immer noch nicht sehr bekannt; nur wenige empirische Studien führen die Bezeichnung Lernerkorpus explizit im Titel.

Die Lernerkorpuslinguistik teilt viele methodische Zugänge mit der allgemeineren Korpuslinguistik, sucht aber spezifische Lösungen für den Umgang mit den teils sehr viel schwieriger zu verarbeitenden lernersprachlichen Daten. Ihr geht es grundsätzlich um Fragen des Erwerbs, der Didaktik und/oder Diagnostik von Fremd- und Zweitsprachen. Damit hat sie breite inhaltliche Gemeinsamkeiten mit der L2-Erwerbsforschung, die ebenfalls von jeher mit Lernerproduktionen arbeitet (die Sammlungen aber eher nicht als Lernerkorpora bezeichnet). Dennoch stehen diese Disziplinen in einem spannungsgeladenen Verhältnis zueinander: Während die Lernerkorpuslinguistik der L2-Erwerbsforschung wegen des Rekurses auf kleine Datengrundlagen und der oft fehlenden Verwendung geeigneter statistischer Analyseverfahren unter anderem mangelnde Generalisierbarkeit vorwirft, bemängelt umgekehrt die Erwerbsforschung das häufige Fehlen einer theoretischen Fundierung der nicht selten deskriptiv und überhaupt eher angewandt ausgerichteten Lernerkorpusstudien. Ein weiterer Kritikpunkt betrifft die Tatsache, dass in der Lernerkorpusforschung häufig mit Korpora gearbeitet werde, auf deren Grundlage sich keine gesicherten Erkenntnisse über den L2-Erwerb ziehen ließen. ‚Erwerbskorpora‘ werden dann als besonders nützlich empfunden, wenn sie in dichten Intervallen mit einer Reihe an Elizitationsformaten longitudinal erhoben wurden und gesprochene Sprache enthalten (s.u.). Typische im Kontext der (quantitativer orientierten) Lernerkorpuslinguistik entstandene Korpora hingegen werden meist eher auch mit dem Ziel einer größtmöglichen Zahl zu inkludierender Lernender und/oder Texte entworfen und weichen deshalb von solchen idealtypischen Erwerbskorpora ab. Gleichzeitig ist festzustellen, dass die Erwerbsforschung zumindest bis vor kurzem wenig Aufmerksamkeit auf die korpuslinguistische Erschließung und öffentliche Bereitstellung der Korpora legte, auf deren Basis andererseits oft grundlegende und sehr weitreichende Erkenntnisse gewonnen wurden (vgl. zur Problematik Myles 2015; McEnery et al. 2019; Wisniewski 2022a).

Charakteristisch für die Lernerkorpuslinguistik ist deren intensive Auseinandersetzung mit aktuellen methodologischen Überlegungen, die in der Nachfolge der Replikationskrise der Psychologie auch die angewandte Linguistik mit Vehemenz erfasst haben; häufig ist von einem methodological turn die Rede (vgl. Paquot / Plonsky 2017; Larsson et al. 2021). Hier stehen zum einen Forderungen nach größerer Transparenz in allen Forschungsphasen im Vordergrund (ein wichtiges Stichwort ist Open Science) sowie das Desiderat für Replikationsstudien und Metaanalysen. Zum anderen werden Qualitätsanforderungen an quantitative Analysen intensiv diskutiert. Dazu gehört etwa eine umfassende und rigide Berichterstattung, aber es werden auch zunehmend komplexe multivariate Analyseverfahren zur Anwendung gebracht.

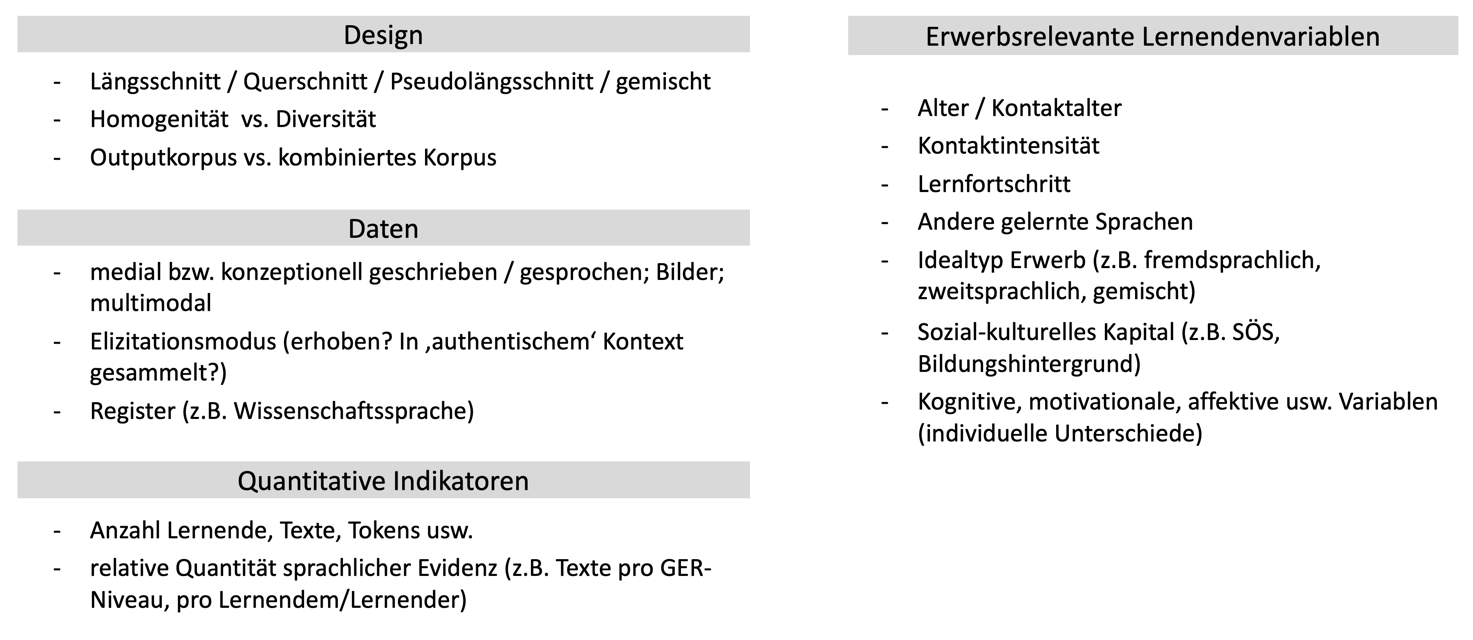

Lernerkorpora entstehen, auch aus Machbarkeitsgründen, im Zusammenhang mit konkreten Forschungsvorhaben und können demzufolge sehr unterschiedliche Designs haben; ein irgendwie repräsentatives und ‚generisches‘ Lernerkorpus ist eine unrealistische Vorstellung. Abbildung 1 stellt – ohne Anspruch auf Vollständigkeit – einige wichtige designbezogene Variationsdimensionen von Lernerkorpora vor.

Lernerkorpora variieren also bezüglich grundlegender Design-Dimensionen. Nicht nur gibt es längs- und querschnittliche Korpora mit ganz unterschiedlichen Strukturen, sondern die Korpora können auch insgesamt einerseits eher homogen angelegt sein mit dem Ziel, Vergleichbarkeit herzustellen und dazu zumindest ausgewählte Variationsdimensionen möglichst zu reduzieren. Das ist etwa beim DISKO4-Korpus (vgl. Wisniewski et al. 2022a) der Fall, wo alle Lernenden dieselbe Schreibaufgabe behandeln. Ferner beschränken sich Lernerkorpora bislang meist auf L2-Outputdaten, während ‚kombinierte‘ oder mehrdimensionale Korpora, die daneben auch (z.B. unterrichtlichen) Input enthalten, noch fehlen (vgl. aber MIKO, Wisniewski et al. 2022b). Gelegentlich werden Outputdaten in gemischtmethodischen Designs ergänzt durch Ergebnisse experimenteller oder andere weitere Erhebungsverfahren, die dann in Form von Metadaten vorliegen (z.B. kognitive Variablen in FD-Lex (Becker-Mrotzek / Grabowski 2018) oder Studienleistungsdaten in DISKO).

Es sind darüber hinaus dann vor allem lernendenbezogene Variablen, die eine sehr große Vielfalt in der Lernerkorpuslandschaft bedingen. Hirschmann / Schmidt (2022) sprechen von vorwiegend sprecherbezogenem Design. Hier dienen also Eigenschaften bestimmter Individuen/Gruppen als Designvariable(n), z.B. Schüler:innen bestimmter Klassenstufen oder GER-Niveaus oder L1. Sowohl die Auswahl der Lernenden als auch die der Gruppierungsvariablen sind dabei unterschiedlich (tief) begründet. Insgesamt ist zu beobachten, dass bei Lernerkorpora teilweise recht wenig Informationen zu den Lernenden (in den Korpusmetadaten oder anderweitig) verfügbar sind. Seit wann genau Lernende Deutsch gesteuert, ungesteuert oder hybrid in Deutschland oder außerhalb in welchen institutionellen Kontexten wie intensiv lernen, sind nur einige der Faktoren, die Erwerbstrajektorien beeinflussen können (vgl. dazu etwa Meisel 2021; Wisniewski / Czinglar / Lüdeling 2022). Auch sogenannte individuelle Unterschiede (z.B. die Sprachlerneignung, die Motivation oder Überzeugungen zum Sprachenlernen) sowie sozioökonomische Rahmenbedingungen spielen, neben anderen Aspekten, eine Rolle. Die inhärent kontrastive Lernerkorpuslinguistik (vgl. Granger et al. 2015) arbeitet jedoch sehr häufig mit Gruppenvergleichen, die auf wenigen und oft nicht sehr detaillierten Gruppierungsvariablen beruhen (etwa: L1 versus L2). Es überrascht nicht, dass die lernersprachliche Variabilität innerhalb solcher Gruppen dann regelmäßig sehr groß ist. Dies zeigen etwa Shadrova et al. (2021) auch für Lernerkorpusdaten von L1-Sprecher:innen, die unerwartet stark variierten (vgl. auch Analysen aus dem RUEG-Vorhaben, Wiese et al. 2022).

Schließlich unterscheiden sich die in Lernerkorpora jeweils enthaltenen ‚Daten‘ diasystematisch, und zwar hauptsächlich hinsichtlich der Modalität (mit einem Überhang geschriebener Korpora) und teils diaphasisch, also funktionell und situativ (z.B. wissenschaftssprachliche Register im GeWiss-Korpus, vgl. Fandrych / Wallner 2023), während regionale und soziolinguistische zielsprachliche Varietätsdimensionen des Deutschen kaum systematisch gespiegelt werden. Textsorten und Diskurstypen in Lernerkorpora lassen sich mit gängigen Textsortenklassifikationen kaum erfassen, da häufig ‚pädagogische‘ Texte (z.B. Aufsätze) vorkommen sowie diagnostische Texte (aus Sprachtests) oder spezifische Erhebungsverfahren verwendet werden. Seltener sammeln Lernerkorpora Daten aus realen (teils auch als ‚natürlich‘ oder ‚authentisch‘ bezeichneten) Kommunikationssituationen (z.B. Prüfungen oder Vorträge in GeWiss).

Ordnend lassen sich trotz dieser Vielfalt ‚Erwerbskorpora‘ von einer großen und sehr heterogenen Gruppe anderer Lernerkorpora unterscheiden. Erwerbskorpora sind dezidiert zur Erforschung des L2-Erwerbs erstellt; es handelt sich um kleinere, longitudinale, gesprochene Lernerkorpora mit wenigen Sprecher:innen meist ab Beginn des Spracherwerbs, vielen Erhebungszeitpunkten und unterschiedlichen Elizitierungsformaten, bislang v.a. zum ungesteuerten Erwerb. Einige deutsche Erwerbskorpora zählen zu den frühesten systematischen L2-Datensammlungen überhaupt (z.B. ZISA-Korpus (vgl. Clahsen et al. 1983), ESF-Korpus (vgl. Klein / Perdue 1993).

Andere Lernerkorpora können verschiedenste weitere Designvariablen in den Vordergrund stellen. Sie zielen oft auf den fortgeschrittenen, gesteuerten bzw. hybriden L2-Erwerb ab und haben Querschnitt- oder pseudolongitudinale Designs. Sie sind überwiegend schriftlich. Zu dieser Gruppe zählen z.B. die DaF-Korpora der FALKO-Familie (vgl. Hirschmann et al. 2022), das auf die Niveaustufen des GER bezogene MERLIN-Korpus (vgl. Wisniewski et al. 2013) und die KOLIPSI-Korpora (vgl. Glaznieks et al. in Vorbereitung). Gesprochene Lernerkorpora des Deutschen dieser Art sind etwa WroDiaCo (vgl. Wesolek / Mooshammer 2021) oder HaMaTaC (vgl. Hedeland et al. 2014). Etliche Korpora werden zudem derzeit zur Veröffentlichung vorbereitet (z.B. das Schweizer Lernerkorpus (SWIKO, vgl. Karges et al. 2022) oder das Deutsch-ungarische Lernerkorpus DULKO (vgl. Beeh et al. 2021). Die Differenzierung dieser beiden Korpusgruppen ist sehr grob, im DAKODA-Kontext, in dem es um dezidiert erwerbsbezogene Fragestellungen geht, jedoch nützlich.

Die ‚Größe‘ betreffend ist zu konstatieren, dass Lernerkorpora sehr aufwändig zu erstellen und deshalb kleiner sind als die meisten L1-Korpora. Gerade die besonders ressourcenintensiv aufzuarbeitenden gesprochenen Lernerkorpora haben einen noch begrenzteren Umfang als geschriebene (vgl. Hirschmann / Schmidt 2022; Wisniewski 2022a). Selbst mit der Möglichkeit der Erstellung dynamisch wachsender Lernerkorpora aus digital verfassten L2-Texten bleibt auf absehbare Zeit die Notwendigkeit manueller bzw. zumindest manuell unterstützter Normalisierungs- und Annotationsarbeit wohl bestehen. Lüdeling et al. (2021) warnen dennoch davor, die Möglichkeit valider Forschung anhand von Lernerkorpora wegen ihrer geringeren Größe gleich von der Hand zu weisen. Die Autor:innen vertreten vielmehr den Standpunkt, dass viele Forschungsfragen eine tiefgreifende, linguistisch gut fundierte manuelle Annotation von Lernerproduktionen erfordern, die ohnehin nur bei von ihnen als mittelgroß bezeichneten Korpora leistbar sei. Dem ist sicherlich zuzustimmen. Gleichzeitig ist natürlich anzustreben, computerlinguistische Lösungen für die automatisierte Lernersprachenannotation zu entwickeln, die dann auch die Verarbeitung größerer Datenmengen erlauben würden.

Abgesehen von der Gesamtgröße von Korpora können diese unterschiedlich umfangreiche lernersprachliche Evidenz zu unterschiedlichen Filtervariablen enthalten, z.B. nur je einen kurzen geschriebenen Text pro Person im MERLIN-Korpus, aber viele Produktionen pro Person in einem längsschnittlichen (aber insgesamt kleineren) Korpus wie DaZ-AF (vgl. Czinglar 2014). Wünschenswert ist gerade wegen der hohen intra- und interindividuellen Variabilität in Lernersprache natürlich eine möglichst reichhaltige Evidenz.

Auch die mittlerweile zahlreichen deutschen Lernerkorpora variieren entlang dieser und weiterer Dimensionen5. Diese Vielfalt ist unbedingt als Reichtum zu verstehen. Dennoch: Es bestehen nach wie vor erhebliche systematische Lücken in der deutschen Lernerkorpuslandschaft. So fehlen, um nur ein Beispiel herauszugreifen, Korpora weniger kompetenter jüngerer DaF-Lernender oder Korpora von Seiteneinsteiger:innen, also Schülerinnen und Schülern mir einer begonnenen ausländischen Bildungsbiographie, die erst zu einem späteren Zeitpunkt deutsch(sprachige) Bildungsinstitutionen besuchen (vgl. Schlauch 2022; Wisniewski 2022b). Deshalb müssen weiter verschiedene Lernerkorpora erstellt werden, um die Heterogenität realer Lehr-Lernkonstellationen auch nur annähernd abzubilden (vgl. auch etwa Tracy-Ventura / Myles 2015).

2.2 Lernerkorpora und die FAIR-Prinzipien

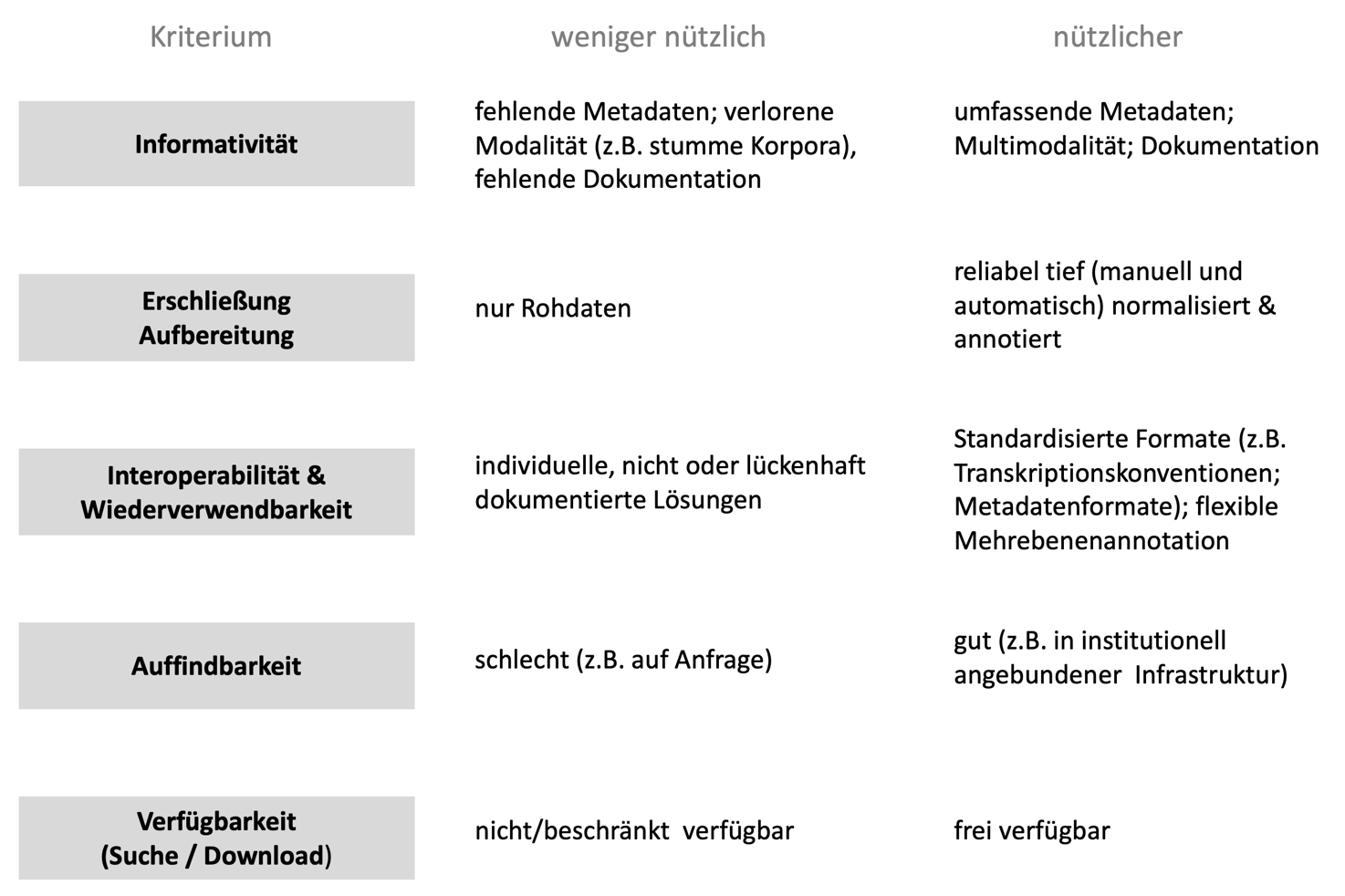

Der Reichtum, den die existierende Lernerkorpuslandschaft darstellt, wäre deutlich leichter auszuschöpfen, wenn Lernerkorpora hinsichtlich ihrer Verfügbarkeit und technischen sowie linguistischen Erschließung gewisse, im Folgenden kurz zu benennende Eigenschaften aufweisen würden. Während entlang der o.g. Designfaktoren (vgl. Abbildung 1) variierende Lernerkorpora jeweils Puzzleteile zu einem – insgesamt noch unvollständigen – Bild von L2-Produktionen darstellen und nicht allein aufgrund dessen nicht als qualitativ besser oder weniger gut beurteilt werden dürfen, fasst Abbildung 2 einige Aspekte zusammen, bezüglich derer Lernerkorpora für die Forschungsgemeinschaft durchaus mehr oder weniger nützlich sein können. Dabei orientieren wir uns an den sogenannten FAIR-Prinzipien, nach denen Forschungsdaten auffindbar (findable), zugänglich (accessible), interoperabel und wiederverwendbar (reusable) sein sollten6. Diese Forderungen spielen im derzeit an Bedeutung gewinnenden Forschungsdatenmanagement und zugehörigen Anstrengungen zur Erschließung und Bereitstellung von Forschungsdaten, vor allem in der Nationalen Forschungsdateninfrastruktur (NFDI) und hier in der Initiative Text +, eine große Rolle7.

Legt man diese Nützlichkeitskriterien auf deutsche Lernerkorpora an, zeigen sich derzeit insgesamt eine große Unübersichtlichkeit und eher heterogene Vorgehensweisen.

2.2.1 Verfügbarkeit: Zugang zu und Nutzbarkeit von deutschen Lernerkorpora

Zu differenzieren ist hier zwischen dem Zugang zu Daten und den dann erlaubten Nutzungsformen durch Endnutzer:innen (z.B. die Weitergabe und/oder Veränderung der Daten oder deren Vervielfältigung). Letzteres wird zunehmend durch standardisierte Endnutzerlizenzen geregelt, v.a. durch CC8- und CLARIN9-Lizenzen. Die Verwendung solcher standardisierter Lizenzen ist dabei erstrebenswert, deckt aber nicht immer die Spezifika (lerner-)korpuslinguistischer Arbeit ab. Lernerkorpora sind besonders flexibel nutzbar, wenn sie frei zur Suche (z.B. über eine Suchschnittstelle) und/oder zum Download zur Verfügung stehen und eine freie Weitergabe und Weiterverarbeitung ermöglichen (wie beim FALKO-Korpus, das unter einer CC-BY-Lizenz publiziert ist)10.

Um eine solch umfassende Nutzung zu ermöglichen, sind nicht nur datenschutz-, sondern mindestens auch lizenzrechtliche Voraussetzungen zu erfüllen, die bereits bei der Planung eines Korpus Berücksichtigung finden sollten. Mit der Einführung der Europäischen Datenschutzgrundverordnung (DSGVO) im Jahr 2018 hat die Sensibilität für datenschutzrechtliche Fragen zwar zugenommen. Lizenzrechtliche Gesichtspunkte der Datennutzung werden demgegenüber in der Praxis häufig übersehen. So müssen Lernende einer Veröffentlichung ihrer Texte und einer Weitergabe an Dritte in einer Einverständniserklärung (unabhängig von Datenschutzfragen) explizit zustimmen. Auch anonymisierte Daten (die nicht unter das Datenschutzrecht fallen) dürfen ohne eine entsprechende Erklärung der Lernenden nicht publiziert werden.

Auch wenn grundsätzlich abzuwägen ist zwischen dem nötigen Schutz sensibler Daten (z.B. vulnerabler Lernender) einerseits und dem Desiderat transparenter Forschung andererseits und sich nicht alle Daten für eine freie Nutzung eignen, sind Lernerkorpora doch auffällig häufig nur einem beschränkten Nutzerkreis zugänglich und stehen nur zu Forschungs-, nicht aber zu Lehrzwecken zur Verfügung. Viele, vor allem ältere und auch datenschutzrechtlich (d.h. nur teilanonymisierte) sensiblere Korpora wiederum sind nur auf Anfrage bei den Datenbesitzer:innen erhältlich (z.B. das ZISA- oder das Augsburger Korpus, vgl. Wegener 1992). Weitere Korpora, darunter teils umfangreiche und aufwändig aufgearbeitete Dissertationskorpora, sind gar nicht veröffentlicht und können auch auf lang absehbare Zeit aus den o.g. rechtlichen Gründen nicht publiziert werden.

2.2.2 Auffindbarkeit von deutschen Lernerkorpora

Auch frei zugängliche deutsche Lernerkorpora sind teils nicht gut auffindbar. Wisniewski (2022a) beschreibt die wichtigsten Speicherorte gesprochener Lernerkorpora des Deutschen, die im Grunde auch für geschriebene Lernerkorpora gelten und in Tabelle 1 aufgeführt sind.

Einige Speicherorte / Suchschnittstellen für Lernerkorpora des Deutschen

| Speicherort | Erklärung, Beispiel | URL |

| The Language Archive, MPI Nijmegen | Überwiegend ältere DaZ-Korpora, z.B. Augsburger Korpus, ESF-Korpus | https://archive.mpi.nl/tla/ |

| Korpusserver der HU Berlin | Überwiegend DaF-Korpora, FALKO-Familie, MERLIN, DISKO. Auch Suchschnittstelle verfügbar (ANNIS11). |

https://www.linguistik.hu-berlin.de/de/institut/professuren/korpuslinguistik/korpora; https://korpling.german.hu-berlin.de/annis3/ |

| Hamburger Zentrum für Sprachkorpora | Unterschiedliche Lernerkorpora, z.B. HaMaTaC | https://www.slm.uni-hamburg.de/hzsk/ |

| Forschungsdatenrepositorium der Universität Hamburg | Unterschiedliche Lernerkorpora, z.B. ZISA-Korpus | https://www.forschungsdatenzentrum.de/de/kontakt/hamburg |

| Zenodo | Allgemeines Repositorium. Enthält ergänzende Texte und Annotationen bestehender Korpora, z.B. Kobalt Extension (Shadrova 2021; Zinsmeister et al. 2012) oder Shadrova et al. (2022) zu Falko | https://zenodo.org/ |

| IRIS Digital Repository | Linguistisches Repositorium. Einzelne ergänzende Annotationen bestehender Korpora, z.B. Wisniewski (2020) zu MERLIN | https://www.iris-database.org/ |

| Institut für Deutsche Sprache - Langzeitrepositorium | Im Aufbau befindliches Repositorium, enthält z.B. DISKO, MIKO | http://repos.ids-mannheim.de/ |

| Institut für Deutsche Sprache: Datenbank Gesprochenes Deutsch (DGD) und Archiv für gesprochenes Deutsch (AGD) | Für gesprochene Korpora, darunter GeWiss und MIKO. Suchschnittstelle (DGD) und Repositorium (AGD). | https://dgd.ids-mannheim.de/ |

| PORTA Learner Corpus Portal der EURAC | Lernerkorpora, die an der EURAC (mit-)erstellt wurden, z.B. KoKo (Abel et al. 2014), Leonide (Glaznieks et al. 2022), Kolipsi-Familie. Download und Suchschnittstelle (ANNIS) |

https://www.porta.eurac.edu/ |

Insgesamt ist die Lage also unübersichtlich. Eine standortübergreifende, institutionell stabil angebundene Infrastruktur, die beispielsweise den einfachen Download mehrerer Korpora ermöglichen würde, gibt es bislang nicht. Ausschließlich in den ANNIS-basierten Schnittstellen in Berlin und bei PORTA der EURAC ist eine korpusübergreifende Suche möglich, sofern sich Endnutzer:innen mit der für Nicht-Expert:innen vielleicht nicht sehr intuitiven Suchplattform ausreichend auseinandersetzen.

2.2.3 Informativität: Fokus Metadaten

Drittens ist eine größtmögliche Informativität von Lernerkorpora wünschenswert. Dazu tragen Metadaten entscheidend bei. Diese betreffen unterschiedliche Dimensionen: Auf Ebene der Lernenden spielen etwa Metadaten zur Art und zum Verlauf des Erwerbsprozess eine wichtige Rolle. Da ein reflektierter Mehrsprachigkeitsbegriff ein differenziertes Umgehen mit erwerbsrelevanten Einflussgrößen erfordert (vgl. ausschnitthaft Abbildung 1), sollten sich diese möglichst in den Metadaten der Lernerkorpora spiegeln: Was mit „L2“ bei einem Individuum jeweils gemeint ist, kann sehr unterschiedlich sein. Auch auf Ebene von Texten und Erhebungssituationen sind Metadaten aber zentral für die Transparenz und somit die Interpretierbarkeit von Lernerkorpusdaten.

Derzeit ist bei vielen Lernerkorpora noch kein zufriedenstellendes Maß an Informativität gegeben, weil nur sehr wenige Metadaten vorliegen, die zudem terminologisch uneinheitlich verwendet werden. Aktuelle Initiativen zur Standardisierung eines Kernbestands an Metadaten aus dem Bereich der internationalen Lernerkorpusforschung versuchen dieser Situation entgegenzuwirken (vgl. König et al. 2022). Erschwerend kommt hinzu, dass Korpusnutzende teils nur umständlich an Metadaten herankommen, im ungünstigsten Fall über die Lektüre von Sekundärliteratur.

2.2.4 Erschließung

Die Informativität hängt ferner auch eng mit der Tiefe und Genauigkeit der technisch-linguistischen Erschließung zusammen. Die valide und reliable Erschließung von Lernerkorpora ist zeitaufwändig und komplex, der Weg zu einem transkribierten und annotierten Korpus weit. Der Umgang mit gesprochenen Daten ist dabei besonders ressourcenintensiv (vgl. ausführlich Hirschmann / Schmidt 2022). Herausforderungen für die Analyse resultieren v.a. aus den zahlreichen nicht zielsprachenkonformen lernersprachlichen Formen, gerade bei beginnenden Lernenden. Bevor sich L2-Produktionen überhaupt manuell oder automatisch (z.B. hinsichtlich bestimmter auftretender Fehler oder auftretender Wortarten) annotieren lassen, sind mehrere Vereindeutigungsprozesse nötig (Normalisierung, Klassifizierung, Segmentierung). Dabei stößt die systematische Aufbereitung und Analyse lernersprachlicher Daten regelmäßig auf grundlegende linguistische und methodische Fragestellungen und erfordert schwierige, teils dilemmatische Entscheidungen, beispielsweise zu sprachlichen Normen, zur Rekonstruktion von Zielhypothesen, zur Abgrenzung linguistischer Ebenen und anderem mehr.

Wurden Texte nicht digital erhoben, müssen sie zunächst richtlinienbasiert transkribiert12 und können dann weiter technisch und linguistisch erschlossen werden. Zur sogenannten ‚Vorverarbeitung‘ gehören in Lernerkorpora häufig Annotationsebenen (auch: -spuren, -tiers), die unterschiedliche Normalisierungen der lernersprachlichen Originalform darstellen; diese sind teils Voraussetzung für aussagekräftige Taggings und Parsings. Dazu gehören Vollalternativen zu den L2-Texten, sogenannte Zielhypothesen. Diese stellen unterschiedlich stark modifizierte Versionen der Lernendentexte dar. Sie können beispielsweise eine rein orthographische oder eine orthographisch-syntaktische korrekte Fassung („minimale Zielhypothese“, vgl. Reznicek et al. 2012) des L2-Originals sein. Solche Zielhypothesen müssen bislang manuell angefertigt werden und sind in nur wenigen Korpora zu finden (z.B. in Korpora der FALKO-Familie und in MERLIN). Sie sind jedoch oft Voraussetzung für eine manuelle und automatische Weiterverarbeitung.

Zur Vorverarbeitung gehören ferner segmentierende bzw. klassifizierende Annotationen linguistischer Einheiten (Tokenisierung, Lemmatisierung, PoS-Tagging, Parsing). Während dies bei L1-Korpora ohne größere Schwierigkeiten automatisiert erfolgt, ist durch die besonderen Merkmale von Lernerkorpora meist eine manuelle Kontrolle unumgänglich.

Neben Vollvarianten der Lernerspur wie in Zielhypothesen enthalten einige Lernerkorpora (z.B. ALesKo (vgl. Zinsmeister / Breckle 2014), MULTILIT (vgl. Schroeder / Schellhardt 2015), FALKO, MERLIN) auch Annotationen bestimmter linguistischer Merkmale der L2-Texte; hier handelt es sich meist um Fehler.

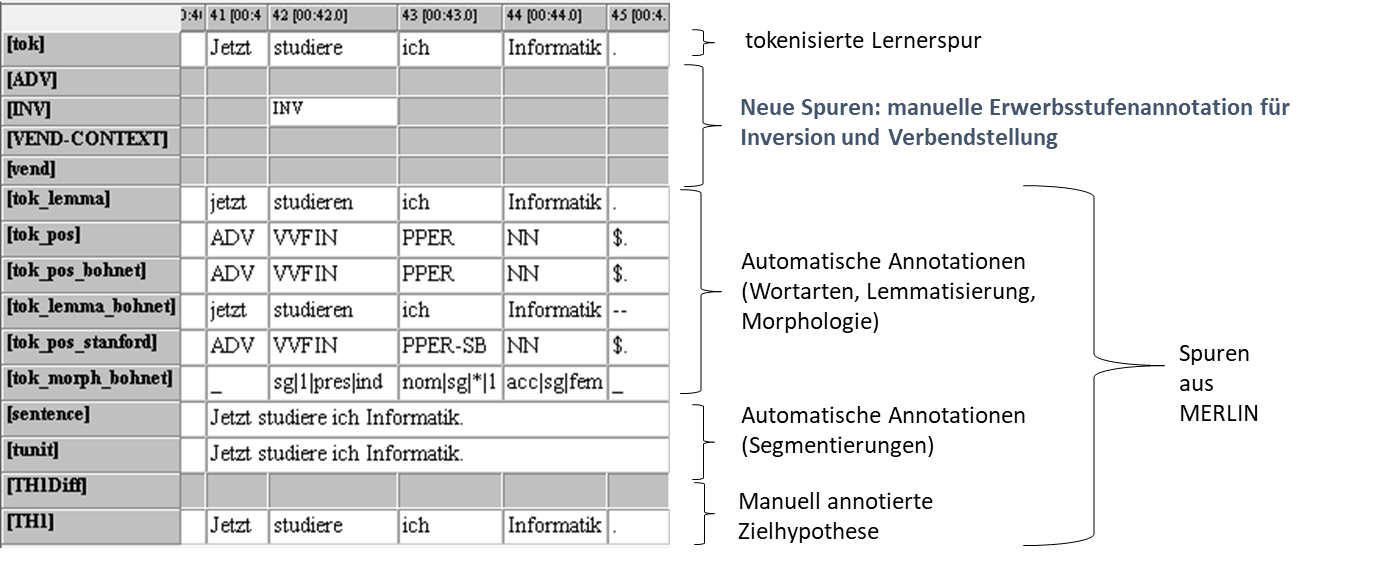

Häufig werden zu einer derartigen Erschließung flexible Mehrebenen-Stand-off-Formate genutzt. Diese können von Endnutzer:innen auch verwendet werden, um auf dem eigenen Computer weitere Spuren zu bestehenden Korpora hinzuzufügen. Abbildung 3 illustriert dies anhand eines Beispiels aus der Studie von Wisniewski (2020), in der MERLIN-Texte heruntergeladen und im EXMARaLDA-Partitureditor (vgl. Schmidt / Wörner 2014) um einige Annotationsspuren oder -tiers erweitert wurden. Gleichzeitig enthält das Beispiel eine minimale Zielhypothese (hier ohne Abweichungen von der Lernerspur, Tier „TH1“ und „TH1Diff“).

Tief erschlossene Lernerkorpora, wie die wohl am intensivsten qualitativ immer wieder überprüften und technisch modifizierten Korpora der FALKO-Gruppe, stehen Lernerkorpora gegenüber, bei denen nicht weiter aufbereitete Rohtexte zum Download zur Verfügung gestellt werden (wie etwa das Korpus der DiGS-Studie, vgl. Diehl et al. 2000). Die Erschließungstiefe ist dabei von den jeweiligen Forschungszielen abhängig; eine größtmögliche Granularität ist nicht immer wünschenswert und noch weniger machbar. Eine größere Tiefe bedingt zudem auch die Gefahr geringerer Annotationskorrektheit bzw. Intercoderreliabilität oder führt dazu, dass nur geringe Textmengen annotiert werden können. Allerdings scheinen eine Tokenisierung und Lemmatisierung sowie zumindest eine orthographische Normalisierung/Zielhypothese in jedem Fall ein wünschenswerter Arbeitsschritt.

2.2.5 Wiederverwendbarkeit und Interoperabilität

Ein wünschenswertes Nützlichkeitskriterium von Lernerkorpora ist schließlich ihre Interoperabilität. Vor allem aus der Vogelperspektive, und das heißt aus dem Desiderat einer umfassenden Lernerkorpusinfrastruktur betrachtet, ist Interoperabilität erstrebenswert. Damit zusammen hängt die bereits besser umgesetzte Wiederverwendbarkeit von Korpora. Wie interoperabel Lernerkorpora sind, ist auch eine Frage der Erschließungsweise und -tiefe (vgl. Abschnitt 2.2.4). Wiederverwertbarkeit und Interoperabilität können einerseits durch die Verwendung möglichst robuster Formate erreicht werden, z.B. bei der Transkription, der Annotation und bei Metadaten (vgl. Stemle et al. 2019; König et al. 2021). Stemle et al. (2019: 24-33) sprechen in diesem Zusammenhang von „struktureller Interoperabilität“. Hier kristallisiert sich für deutsche Lernerkorpora einerseits die häufige Verwendung der CHILDES-Toolbox (mit CHAT-Transkriptionskonventionen und CLAN-Tools13) heraus, gerade bei Erwerbskorpora. Andererseits nutzen viele Korpora eine Kombination aus etwa dem EXMARaLDA-Partitureditor (vgl. Schmidt / Wörner 2014), anderen xml-basierten Editorentools oder Excel für Transkription und Annotation und dazu die Suche im Visualisierungstool ANNIS (z.B. FALKO-Familie, MERLIN, DISKO, EURAC-Familie; vgl. auch Hirschmann / Schmidt 2022 für eine umfassendere Übersicht zu unterschiedlichen Werkzeugen)14.

Interoperabilität ist jedoch auch auf konzeptueller Ebene herzustellen (vgl. Stemle et al. 2019), was bei Lernerkorpora eine besondere Herausforderung darstellt. Hier geht es zum Beispiel um die Standardisierung von Metadaten, aber auch um die verschiedenen Erschließungsschritte, die für Lernerkorpora typisch sind. Verschiedenen Lernerkorpusprojekten liegen unterschiedliche Auffassungen linguistischer Grundbegriffe zugrunde, und auch entsprechende Tools beruhen auf durchaus verschiedenen sprachtheoretischen Annahmen und können so ohnehin auch zu unterschiedlichen Ergebnissen führen. Stemle et al. (2019: 6) kommen zu dem ernüchterten Schluss:

Looking at all this from the perspective of comparability of different corpora and different research studies, which should be objective, repeatable, and reproducible, it is striking how difficult it is to compare the results from one corpus with results from another corpus or even with results from the same corpus at another time.

Wir schlussfolgern: Der (noch) etwas orchideenhaft anmutende Status von Lernerkorpora bzw. der Lernerkorpusforschung (zumindest unter diesem Namen) widerspricht dem enormen Potenzial dieser Daten und zugehöriger aktueller Methoden für die Erforschung von L2-Erwerbstrajektorien und für einen Transfer von Befunden in die didaktische und diagnostische Praxis. Im Vergleich zu nicht publizierten L2-Datensammlungen stellt die öffentliche Bereitstellung von Lernerkorpora einen beträchtlichen Zuwachs an Transparenz und damit Replizierbarkeit dar. Demgegenüber beruhen viele wegweisende Erwerbsstudien aus dem DaF/DaZ-Bereich – oft aus gut nachvollziehbaren rechtlichen oder ökonomischen Gründen – noch auf nicht oder nur extrem schwer zugänglich publizierten Daten und sind somit nicht bzw. nicht mit vertretbarem Aufwand replizierbar. Öffentliche Korpora ermöglichen hingegen problemlos Anschlussforschung, insbesondere wenn sie in flexiblen Mehrebenenannotationsformaten publiziert sind.

Gleichzeitig zeigen sich viele Desiderata: So sollte die deutsche Lernerkorpuslandschaft bunter und größer werden, um wichtige konzeptionelle Lücken zu schließen. Zudem sollte perspektivisch daran gearbeitet werden, auch kleinere, tief annotierte Lernerkorpora je nach Machbarkeit und Sinnhaftigkeit nach den FAIR-Prinzipien aufzubauen und öffentlich zugänglich zu machen. Dazu ist im Fach und insbesondere beim wissenschaftlichen Nachwuchs der Ausbau von Kompetenzen in datenschutz- und lizenzrechtlichen, aber auch forschungsethischen Wissensfeldern vonnöten. Was die technische und linguistische interoperable Erschließung betrifft, steht die Lernerkorpusforschung noch vor erheblichen Herausforderungen. Eine Lernerkorpusinfrastruktur, die kleine und mittelgroße Lernerkorpora gemeinsam herunterladbar und durchsuchbar macht, ist ein wichtiges Desiderat.

Das in diesem Beitrag vorzustellende DAKODA-Projekt hat nicht zum Ziel, eine allgemeine Lernerkorpusinfrastruktur des Deutschen zu erstellen und kann die genannten Probleme nicht auflösen. Es ist aber gleichzeitig sehr deutlich geprägt von der hier geschilderten Gesamtsituation. Anliegen von DAKODA ist, mehrere bereits erschlossene kleine und mittelgroße Lernerkorpora zusammenzutragen und soweit möglich auch für die Forschungsgemeinschaft nutzbar zu machen, um sie hinsichtlich einer spezifischen Forschungsthematik zu analysieren. Dabei handelt es sich um die gut erforschten syntaktischen Erwerbsstufen des Deutschen und die Exploration der Frage, ob und wie zuverlässig sich diese computerlinguistisch analysieren lassen.

2.3 Syntaktische Erwerbsstufen

2.3.1 Erwerbsstufen in der Processability Theory

Stufenmodelle gehen für einen grammatischen Kernbereich von einem streng sequenziellen L2-Erwerb aus. Die Stufen des Verbstellungserwerbs sind hier das vielleicht am intensivsten beforschte Einzelphänomen im L2-Erwerb (des Deutschen). Bereits im ZISA-Projekt (Zweitspracherwerb italienischer und spanischer Arbeiter; vgl. Meisel / Clahsen / Pienemann 1981; Clahsen / Meisel / Pienemann 1983) wurden interindividuell robuste Muster beim Erwerb v.a. der Verbstellung des Deutschen gefunden und im sogenannten Multidimensional Model erklärt (für einen kurzen historischen Abriss vgl. Lenzing et al. 2019). Die theoretische Schärfung fand danach vor allem in der psycholinguistisch geprägten Processability Theory statt (im Folgenden PT; vgl. Pienemann 1998, 2005; Lenzing et al. 2019). Das PT-Framework wird stetig erweitert (vgl. etwa Bettoni / Di Biase 2015). Viele Studien befassen sich aber auch ohne PT-Bezug mit den Stufen des Verbstellungserwerbs (vgl. etwa Czinglar 2014a, 2014b). Zudem erfahren sie in vielen sprachdiagnostischen Kontexten in sogenannten Profilanalysen (Grießhaber 2012) sehr breite Verwendung, die mit einer leicht veränderten Stufungssystematik arbeiten (welche sich mit den PT-Annahmen nicht ohne weiteres in Übereinstimmung bringen lässt).

Ausgewählte Studien zu den Erwerbsstufen im Deutschen sind beispielsweise Bohnacker (2006), Czinglar (2014a, 2014b), Diehl et al. (2000), Haberzettl (2005, 2012), Jansen (2008), Jansen / Di Biase (2015), Meerholz-Härle / Tschirner (2001), Pienemann (1998), Schlauch (2022), Schwendemann (2022) und Wisniewski (2020). Diese bestätigen sowohl für gesprochene als geschriebene Sprache als auch für gesteuerte und ungesteuerte Erwerbskontexte im Großen und Ganzen den stufenförmigen Erwerb, allerdings mit Unterschieden je nach dem Kontaktalter, teils auch bezüglich der L1 (vgl. Håkansson / Arntzen 2021) sowie teils in Abhängigkeit bestimmter kontextueller sprachlicher Bedingungen (vgl. Dimroth 2019 für einen Überblick). Insgesamt wird der kindliche und jugendliche L2-Erwerb in PT-Studien eher ausgeklammert (vgl. dazu Dimroth 2019). Vorliegende Studien – gerade zu gesprochener Sprache – arbeiten oft (gezwungenermaßen) mit kleinen Proband:innengruppen. Methodisch problematisch ist, dass Analysen größerer Lernendengruppen kaum je die intra- und interindividuelle Variation berücksichtigen; dann werden beispielsweise Befunde über Gruppen aggregiert, ohne distributionelle Detailinformation anzuführen.

Grundgedanke der Erwerbsstufensystematik (engl. developmental stages, sequences, seltener trajectories, vgl. Pienemann 2015) in der PT ist, dass aus Gründen der kognitiven Verarbeitbarkeit bestimmte grammatische Strukturen in einer aufeinander aufbauenden Reihenfolge erworben werden müssen. Der stufenförmige Erwerbsverlauf trägt Implikationscharakter: Höhere Stufen setzen niedrigere zwingend voraus, und es können keine Stufen übersprungen werden (vgl. Rickford 2004). Spracherwerb wird als durch die Verarbeitbarkeit (processability) beschränkt verstanden. Dabei beruft sich die PT auf das Sprachproduktionsmodell von Levelt (1989). Zu Beginn der Theorieentwicklung lag der Fokus v.a. auf der sukzessiv zu erwerbenden grammatischen Enkodierung im Formulierer. In jüngerer Zeit wurden aus diskurspragmatischer Perspektive auch die Rolle des Konzeptualisierers und das Lexikon thematisiert (vgl. Pienemann et al. 2005) sowie Automatisierungsprozesse (vgl. Bettoni / Di Biase 2015).

Linguistisches Fundament der PT ist die Lexical Functional Grammar (LFG; vgl. Bresnan et al. 2015; Dalrymple / Mycock 2019), ein unifikationstheoretischer phrasenstrukturgrammatischer Ansatz. Die beschränkungsbasierte, nicht-derivationelle LFG differenziert zwischen den linguistischen Repräsentationsebenen einer Konstituenten-, einer Argument- sowie einer funktionalen Struktur. Es wird angenommen, dass Lernende Schritt für Schritt die Fähigkeit erwerben, grammatische Informationen zwischen zunehmend großen und auch diskontinuierlichen sprachlichen Einheiten auszutauschen; die wichtigste Bezugseinheit ist dabei die Phrase15. Dieser Informationsaustausch (feature unification) bedarf der Identifikation der passenden grammatischen Informationen im Lexikoneintrag, der Zwischenspeicherung dieser Information und ihrer Verwendung an einem anderen Punkt der Konstituentenstruktur (vgl. Pienemann 1998: 91).

Die PT fokussiert einen engen Ausschnitt v.a. syntaktischer und morphologischer Phänomene. Wir konzentrieren uns im Folgenden vor allem auf erstere. Im Zentrum stehen dabei Verbstellungsregularitäten. Zu Beginn des L2-Erwerbs verwenden Lernende Einzelwörter und Chunks: „This means that all that can happen at this stage is the mapping of conceptual structures onto individual words and fixed phrases“ (Pienemann 1998: 83). Daran anschließend erfolgt der Erwerb in der folgenden Systematik:

Erwerbsstufen im PT-Framework.

| Bezeichnung | Kanonische Wortstellung |

| Kürzel | SVO/SOV16 |

| Kernindikator | Ausschließlich SVO/SOV oder Routinen (Bettoni/Di Biase 2015: 62) |

| Erklärung | Kanonische Wortstellung der Zielsprache, strikt seriell. |

| Carla kauft Brot | |

|

|

| Bezeichnung | Besetzte Fokusposition mit kanonischer Wortstellung |

| Kürzel | ADV |

| Kernindikator | Besetzte Salienzposition am Satzanfang XP + SVO |

| Erklärung | Nicht zielsprachenkonform. Wie SVO, aber W-Wörter, Präpositionalphrasen, Adverbien und Nominalphrasen können in Salienzposition (XP) auftreten, ohne die kanonische Wortstellung zu tangieren. Weiterhin kein Rückgriff auf funktionale Strukturebene, keine Unifikation. |

| *heute ich habe ihn gesehen | |

| S ➔ XP SVO | |

| Bezeichnung | Phrasenprozedur, Verbseparation |

| Kürzel | SEP |

| Kernindikator | Distanzstellung von finitem Verb (Auxiliar, Modalverb) und Partizip17 |

| Erklärung | Erwerb der VP als Konstituente, damit Argumentstruktur lexikalischer Verben + Erwerb der Distanzstellung (Verbklammer). |

| ich habe ihn gesehen | |

|

|

| Bezeichnung | Satzprozedur, Inversion |

| Kürzel | INV |

| Kernindikator | V2 in Inversionskontexten mit besetzter XP-Position in Hauptsätzen und Ergänzungsfragen (dazu Jansen / di Biase 2015) |

| Erklärung | Austausch von grammatischer Information über Phrasengrenzen hinweg (interphrasale Unifikationsprozeduren). Systematischer Phrasenausbau zu Sätzen durch Zuordnung von Phrasenfunktion; von unmarkierter zu syntaktisch kodierter Wortstellung. |

| Heute habe ich ihn gesehen. | |

| S‘ ➔ (V) S | |

| Bezeichnung | Nebensatzprozedur, Verbendstellung |

| Kürzel | VEND |

| Kernindikator | Endstellung des finiten Verbs im Nebensatz |

| Erklärung | Differenzierung zwischen Haupt- und Nebensätzen, d.h. Austausch von grammatischer Information über Satzgrenzen hinweg |

| Ich habe gesehen, dass zwei Kinder im Garten gespielt haben. | |

| S ➔ (COMP)ROOT=- NPsubj (NPobj1) (NPObJ2) (ADJ) (V)INF=- (V) INF=+ |

S = Satz, NP = Nominalphrase, VP=Verbalphrase; V = Verb; V-COMP = infinites Verb mit allen Argumenten; XP = Fokusposition; COMP = Komplementierer, ROOT = Matrixsatz, INF = Finitheit. Fiktive Beispiele.

In jüngerer Zeit ist diese Stufensystematik im Rahmen der sogenannten Prominence Hypothesis und der Lexical Mapping Hypothesis modifiziert worden (vgl. Pienemann et al. 2005; Di Biase / Bettoni 2015), die hier nur sehr knapp erwähnt werden können und weniger verbreitet sind als die in Tabelle 2 angegebenen Stufen. Die Prominence Hypothesis (Bettoni / Di Biase 2015: 63) zielt auf die Syntax-Diskurs-Schnittstelle und besagt vereinfacht ausgedrückt, dass Lernende zu Beginn noch nicht zwischen grammatischen und Diskursfunktionen differenzieren. Subjekt und Topik fallen so stets aufeinander. Die Differenzierung dieser Ebenen beginnt, wenn Elemente in die XP-Position gesetzt werden (vgl. Stufe ADV). Das kann ein Topik (in Deklarativa) oder ein Fokus (in Fragesätzen) sein; wichtig ist, dass die kanonische Wortstellung zunächst nicht verändert wird. Im nächsten Schritt wird diese besetzte XP-Position mit nicht-kanonischen Wortstellungen verknüpft (vgl. Stufe INV). Die Lexical Mapping Hypothesis (vgl. Bettoni / Di Biase 2015: 63: 68) zielt auf das Verhältnis von Argument- zu Konstituentenstruktur. Die Annahme ist, dass Lernende zunächst die höchste semantische Rolle generell mit dem Subjekt gleichsetzen (default mapping), wovon sie sich sukzessiv in Richtung anderer Relationen bewegen (nondefault mapping, wie beim Passiv).

In der PT gilt als Evidenz für den Erwerb der Stufen je die ‚Emergenz‘ des in der Stufenübersicht erwähnten Kernindikators („key grammatical encoding phenomenon“, Pienemann 1998: 6, 13). Lernende haben genau dann eine Stufe erreicht, wenn sie deren Kernindikator „in principle“ (Pienemann 1998: 138) kognitiv verarbeiten und damit auch produzieren können. Als Nachweis gilt bei syntaktischen Phänomenen im Grunde ein einziges Vorkommen (Beleg) des Indikators in lernersprachlichen Produktionen. Meist wird aber festgelegt, dass der Kernindikator-Beleg in einer zu bestimmenden Mindestzahl obligatorischer Kontexte, in denen seine Verwendung zielsprachlich erforderlich wäre, erfolgen muss, damit die Stufe als gemeistert bzw. emergiert gilt (zur uneinheitlichen Verwendung von Emergenzkriterien vgl. Pallotti 2007). So soll verhindert werden, dass nicht produktiv gebrauchte (z.B. auswendig gelernte) Strukturen fälschlich als erworben gelten. In Lernersprachenanalysen gilt es damit also einerseits Slots zu finden, in denen die Verwendung eines Kernindikators zwingend ist (obligatorische Kontexte) und andererseits darum auszuzählen, wie oft Lernende an diesen Stellen den Indikator tatsächlich genutzt haben (Belege). Die überwältigende Mehrheit der Studien zu syntaktischen Erwerbsstufen arbeitet mit einer Mindestzahl von drei bis fünf obligatorischen Kontexten pro L2-Produktion und einem Mindestbeleg.

Um festzustellen, dass ein:e Lernende:r eine Erwerbsstufe noch nicht erreicht hat, dürfte demgegenüber in den je angelegten minimal nötigen obligatorischen Kontexten kein einziges Mal die zielsprachliche Form verwendet werden. Den Nicht-Erwerb syntaktischer Stufen so nachzuweisen ist nicht trivial. Dazu müssen ausreichend obligatorische Kontexte ohne zielsprachliche Realisierung des Kernindikators zu finden sein (Problem der negativen Evidenz)18. Überhaupt ist das Konzept der obligatorischen Kontexte bei syntaktischen Erwerbsgegenständen schwierig19. Bettoni / Di Biase (2015: 76) postulieren deshalb, dass lediglich Belege zu zählen seien, obligatorische Kontexte jedoch keine Rolle spielen dürften. Gerade für eine computerbasierte Analyse, wie sie in DAKODA unternommen werden soll, sind die Definierbarkeit und das zuverlässige, exhaustive Retrieval obligatorischer Kontexte wichtig, aber hoch anspruchsvoll. Das Problem entfiele aber, wenn in einem Text die Zahl der gefundenen Belege für einen Kernindikator mindestens genauso hoch ist wie eine zu postulierende angelegte Mindestzahl obligatorischer Kontexte. Man lege beispielsweise fest, dass eine Stufe als emergiert gelten möge, wenn mindestens vier obligatorische Kontexte auftreten. Finden sich nun ungeachtet der Zahl der obligatorischen Kontexte vier Belege für die entsprechende Struktur, kann automatisch von einer Emergenz ausgegangen werden. So kann die dazugehörige Erwerbsstufe auch ohne Auszählung aller obligatorischen Kontexte als emergiert gelten – solange sich ausreichend Belegstellen finden.

Sicherzustellen ist bei den auch als Implikationsanalysen bezeichneten Stufenuntersuchungen zudem die ‚Produktivität‘ der Evidenz, d.h. zum Beispiel der Ausschluss als Ganzes gelernter sprachlicher Einheiten (Chunks, Formeln usw.) und die Berücksichtigung ausschließlich wirklich valider Belege, idealiter an gesprochenen Samples20. Hierfür werden in empirischen Studien unterschiedliche Ansätze gewählt, was Auswirkungen auf die Befunde und Vergleichbarkeit empirischer Analysen haben kann. Da sich linguistisch oft plausibel für unterschiedliche Lösungen argumentieren lässt und zudem methodisch kaum möglich ist zu entscheiden, ob ein:e bestimmte:r Lernende:r an einer konkreten Textstelle eine Struktur blockartig aus dem mentalen Lexikon abgerufen hat oder aber frei produziert hat, ist hier eine ganze Bandbreite an Entscheidungen über auszuschließende und zu berücksichtigende Analyseeinheiten denkbar. Von besonderer Bedeutung scheint deshalb eine transparente Dokumentation des jeweiligen Vorgehens.

Implikationsanalysen zeigen dann – idealiter – einen streng stufenförmigen Erwerb, oft in treppenartiger Form visualisiert. Wir erläutern und hinterfragen dies unten genauer, möchten aber zunächst noch kurz näher auf den Gedanken der die Stufen jeweils repräsentierenden ‚Kernindikatoren‘ eingehen, da dieser für den Projektkontext eine zentrale Rolle spielt. Zu jedem Niveau der Verarbeitbarkeitshierarchie (vgl. Tabelle 2) gehört potenziell ein Spektrum sprachlicher Phänomene mit vergleichbaren Verarbeitungsanforderungen. Beispielsweise wird nicht nur die Inversion auf Ebene der Satzprozeduren erworben, sondern dazu gehört auch etwa das Subjekt-Verb-Agreement. Dennoch wird analytisch in der Regel genau ein Indikator für den Stufenerwerb angesetzt, und zwar:

a structure that displays possibly the clearest one-to-one relationship between form and function, or the most representative, or default, structure of a stage in a particular schedule, the one with the most transparent conceptual meaning. (Bettoni / Di Biase 2015: 74)

Deshalb sind die Kernindikatoren sprachspezifisch (für die S-Prozedur wird für Englisch beispielsweise Subjekt-Verb-Agreement genutzt), die Verarbeitungsprozeduren aber sprachübergreifend.

In jüngerer Zeit wird nun vermehrt darauf verwiesen, dass innerhalb der Erwerbsstufen verschiedene verarbeitungsäquivalente sprachliche Phänomene noch einmal in einer geordneten Abfolge erworben werden könnten. Bettoni / Di Biase (2015) sprechen dabei von soft barriers. Das hatte bereits Pienemann (1998) vermutet; mittlerweile wird das Desiderat der Untersuchung stufeninterner Entwicklungen aber immer stärker betont (vgl. Lenzing et al. 2019). Zustandekommen können solche unterschiedlichen Erwerbsreihenfolgen innerhalb von Stufen etwa durch bestimmte lexikalische Eigenschaften einzelner Wörter oder Klassen oder durch spezifisch mit bestimmten Strukturen zusammenhängende Verarbeitungsherausforderungen (vgl. Bettoni / Di Biase 2015: 75). Dies wäre auch gut für den möglicherweise gestaffelten Erwerb innerphrasaler Prozeduren (innerhalb von SEP) in NP versus VP im Deutschen denkbar.

2.3.2 Erwerbsstufen und lernersprachliche Variation

Neben der Systematizität (die sich etwa in stufenartigen Entwicklungen ausdrücken kann) ist von jeher auch die Variabilität ein wichtiges Explanandum – teils auch Explanans – lernersprachlicher Entwicklung. In jüngster Zeit erfährt die L2-Variation (erneut) sehr viel Beachtung. In der PT spielt die Variation eine wichtige, wenn auch sehr theoriespezifische und eng umrissene Rolle. Pienemann (1998) gesteht umfassende Variationsmöglichkeiten innerhalb und zwischen Erwerbsstufen zu; in der Folge sind diese unseres Wissens aber kaum je empirisch analysiert worden (vgl. jedoch Dyson 2021). Da es der Theorie gerade um die überindividuelle Systematik der Stufen geht, sind lernendeninterne (mit Ausnahme der L1) und -externe Variablen (mit Ausnahme einiger Studien zum Aufgabeneinfluss, s.u.) konzeptionell und in der empirischen Arbeit der PT nachrangig.

Grundsätzlich wird Variation in der PT als systematisch verstanden und in einem Hypothesenraum (hypothesis space) angesiedelt, der eine Erwerbs- und eine Variationsdimension enthält (vgl. Pienemann 1998). Variation darin wird durch die Verarbeitungsprozesse beschränkt verstanden, die den Lernenden in ihrem Erwerbsprozess gerade zur Verfügung stehen (vgl. Tabelle 2). Es interessiert ausschließlich die Variation der o.g. stufenrelevanten Erwerbsphänomene. Variation passiert in einem Spielraum, der auf jeder Stufe offenbleibt und ist

a degree of leeway at every level of the hierarchy in how different grammatical forms conform to the constraints of the given level. This gives rise to variable L2 forms, i.e., to IL [interlanguage, die Autor:innen] variation. (Pienemann et al. 2022: 7)

Lernende können mit Erwerbsproblemen21 unterschiedlich umgehen, haben aber immer nur eine stark begrenzte Zahl an Optionen zur Wahl. Sie können etwas weglassen (omission, vgl. Beispiel (1)), eine zielsprachliche Regel verletzen (violation vgl. Beispiel (2)) oder versuchen, Fehler zu vermeiden (error avoidance, vgl. Beispiel (3); vgl. Dyson 2021). Diese Optionen werden als exhaustiv postuliert, d.h. man geht davon aus, alle Variationsoptionen vorhersehen zu können. Eine Lernende, die vor dem Erwerbsproblem der Inversion steht, könnte folgende Variationsoptionen wählen (fiktive Beispiele; vgl. Dyson 2021: 9 für ein weiteres Beispiel).

- (1)

- Weglassen von V oder Subjekt

- a.

- *Heute ich Kuchen.

- b.

- *Heute esse Kuchen.

- (2)

- Regelverletzung

- a.

- *Heute ich esse Kuchen.

- (3)

- Vermeidung von Fehlern, z.B.

- a.

- ?Ich esse Kuchen heute.

Zweitens wird zwischen sogenannten trailers (Anhängern) und scouts (Kundschaftern) differenziert (vgl. Pienemann 1998; Dyson 2021). Trailers sind Erwerbsgegenstände, die lange vermieden werden; man zieht sie sozusagen hinter sich her. Erst kurz vor dem Erwerb des Kernindikators der nächsten Stufe werden trailers schließlich in Lernerproduktionen verwendet (z.B. Distanzstellung des Verbs erst direkt vor der Inversion), weshalb es so aussehen kann, als entstünde eine Lücke im Stufenerwerb. Die scouts hingegen sind solche Erwerbsgegenstände, die auf der zugehörigen Verarbeitbarkeitsstufe wirklich erworben werden. Im Umgang mit diesen beiden Dimensionen manifestiert sich eine, so wird angenommen, innerhalb von Lernenden konsistente „Variationsorientierung“ (vgl. Dyson 2021: 10-11; Pienemann et al. 2022). ‚Vereinfachend orientierte‘ Lernende verletzen eher Grammatikregeln oder lassen sprachliche Elemente weg, wenn sie mit Erwerbsproblemen konfrontiert werden (wie in Beispiel 1 und 2 oben); solche Lernende nutzen häufig scouts und produzieren weniger korrekte, aber expressive Lernersprache. ‚Standardorientierte‘ Lernende hingegen bemühen sich, Fehler zu vermeiden (wie in Beispiel 3 oben), nutzen mehr trailers und produzieren korrektere, aber weniger expressive Lernersprache. Lernende der zuletzt genannten Orientierung stagnieren, so die Annahme, oft in ihrer sprachlichen Entwicklung früher (deshalb auch „wrong track pathway“, Pienemann et al. 2022: 10)22. Diese Annahmen sind bislang nur selten Gegenstand empirischer Analysen gewesen (vgl. Dyson 2021; Pienemann et al. 2022).

Der Fokus auf den überindividuell konstanten, linear stufenförmigen Erwerb syntaktischer und morphologischer Gegenstände und das sehr spezifische Verständnis der Rolle und Art lernersprachlicher Variation setzt die PT in ein Spannungsverhältnis zu aktuellen variationsfokussierten Theorien des L2-Erwerbs. In unterschiedlichen gebrauchsbasierten Herangehensweisen (vgl. Tomasello 2003; Ellis 2019; Wulff / Gries 2020), die den Spracherwerb als inputgeleiteten, itembasierten bottom-up-Prozess ansehen, rückt lernersprachliche Variation als Motor des L2-Erwerbs ins Zentrum. Dies gilt am prononciertesten für die Theorie komplexer dynamischer Systeme (englisch complex dynamics systems theory, CDST, vgl. etwa de Bot et al. 2007; Verspoor / Lowie 2021). Entsprechende Studien verweisen darauf, dass der L2-Erwerb zumindest zeitweise von erheblicher Instabilität geprägt ist, nicht-linear verläuft und von der Interaktion mehrdimensionaler und kaum vorhersehbarer Dynamiken geprägt ist. Larsen-Freeman (2005: 592) formuliert: „There is a great deal of variation at one time in learners’ performances and clear instability over time“. Die PT-Annahme eines geordneten, linear stufenförmigen Erwerbs steht Prämissen der CDST somit diametral gegenüber.

In jüngerer Zeit gewinnt der Faktor Variation im PT-Framework zwar an Bedeutung; Nicholas et al. (2019) etwa nennen die Untersuchung der sprachlichen Variation innerhalb von Erwerbsstufen als zentrales Forschungsdesiderat der PT. Dennoch stehen PT und variationsfokussierende Ansätze wie die CDST in einem ausgeprägten Spannungsverhältnis zueinander (vgl. Pienemann et al. 2022). Mehrfach wurden Versuche unternommen, die PT gegenüber der CDST zu positionieren, wobei häufig PT-Vertreter:innen zwar den ‚dynamischen‘ Charakter der PT betonen, sich aber von den Annahmen der CDST scharf abgrenzen (vgl. Pienemann 2015; Dyson 2022; Lenzing et al. 2022; Pienemann et al. 2022). Dabei unterscheidet sich nicht nur das Verständnis von Variation ganz erheblich, sondern die beiden Ansätze differieren bereits auf grundlegender, erkenntnistheoretischer Ebene.

Auch ohne den theoretischen Annahmen der CDST im Detail zu folgen (vgl. pointiert kritisch Pallotti 2021), bietet nicht nur die hier grundsätzlich breitere Berücksichtigung empirisch nachweisbarer Variation, sondern auch das dafür entwickelte methodische Instrumentarium u.E. Vorteile. Die CDST nutzt innovative Analyseverfahren, mit deren Hilfe intra- und interindividuelle Variation detailliert herausgestellt werden kann, wie etwa longitudinale Clusteranalysen, gleitende Korrelationen oder sogenannte Change-Point-Analysen (vgl. MacIntyre et al. 2017). Diese Verfahren wurden bislang nicht auf die Erwerbsstufen angelegt; Schwendemann (2022, 2023) verwendet aber in seiner Longitudinalstudie zum Syntaxerwerb arabischsprachiger erwachsener Deutschlernender einige der genannten Methoden zur Analyse von Erwerbsstufen. Er kann so unter anderem zeigen, dass vermeintlich klare Gruppentrends bei der Erwerbsreihenfolge auf individueller Ebene nicht mehr beobachtbar waren und Uneindeutigkeiten bei der Sequenzierung auftraten. Außerdem waren die produzierten L2-Texte insgesamt von immenser Variabilität und Nichtlinearität geprägt. Deshalb erscheint es uns sinnvoll, den Stufencharakter des Erwerbs auch mit dem detaillierten Methodeninstrumentarium der CDST genauer ins Auge zu fassen. Auf diesem Wege ließen sich beispielsweise Erwerbsverläufe nach oder direkt vor der Emergenz einer Stufe oder Phasen größerer oder geringerer Stabilität usw. aus variationeller Perspektive weiter beobachten.

Schließlich ist zu konstatieren: Obwohl die für DAKODA zentralen Erwerbsstufen (in ihren hard barriers) als recht robust beforscht gelten können, bleibt eine ganze Reihe an Themen bislang empirisch noch nahezu unbearbeitet. Zu den wichtigsten Forschungsdesiderata (in zunehmend unorthodoxer Distanzierung vom originalen theoretischen Ansatz) zählen:

Einzelanalysen zu morphologisch-syntaktischen Gegenständen jenseits der Kernindikatoren (vgl. Tabelle 1), deren Verarbeitungsniveau den Stufen zugeordnet werden kann, um ein breiteres Spektrum an Erwerbsgegenständen in der Stufenlogik zu beforschen (z.B. Numerus- oder Genuserwerb, Subordinationstypen usw.);

Intra-Stufenentwicklungen und -zusammenhänge (soft barriers) durch Analysen mehrerer zumindest nahezu verarbeitungsäquivalenter Erwerbsgegenstände pro Erwerbsstufe (z.B. Subjekt-Verb-Agreement und Inversion auf Stufe Satzprozedur; innerphrasale Prozeduren in NP und VP; Morphologie- und Syntaxphänomene einzelner Stufen);

Analysen zur Abhängigkeit des Auftretens von Kernindikatoren und anderen stufenrelevanten Phänomenen (vgl. Punkte 1-2) von bestimmten sprachlichen Kontexten (z.B. Inversion in bestimmten Vorfeldtypen und -funktionen, SEP in Abhängigkeit semantisch-lexikalischer Verbeigenschaften);

Zusammenhang PT-relevanter morphologisch-syntaktischer Gegenstände mit anderen sprachlichen Phänomenen, die außerhalb des Fokus der Theorie liegen. Hier ist nicht nur der Wortschatz von Interesse, sondern insgesamt funktionaler orientierte Aspekte der Sprachkompetenz. Dies wird z.B. im Multiplicity Model von Nicholas/Starks (2019), das aus der PT heraus entwickelt wurde, avisiert. Ein Desiderat ist auch die Herstellung von Zusammenhängen mit den Kompetenzstufen des GER (vgl. Abschnitt 2.5) sowie mit der sprachlichen Komplexität (vgl. Abschnitt 2.4).

2.4 Sprachliche Komplexität im L2-Erwerb

Die Erwerbsstufen der Processability Theory fokussieren einen eng umrissenen morphosyntaktischen Phänomenbereich und betrachten auch Variation unter einer sehr spezifischen Perspektive. Wie diese Erwerbsgegenstände sich zu anderen entwicklungssensitiven lernersprachlichen Charakteristika verhalten, ist deshalb eine wichtige Frage. Zwar mögen diese sprachlichen Merkmale für die Erwerbssystematik aus PT-Perspektive keine Rolle spielen, sie vermögen aber, theoretisch eklektischer gedacht, potenziell ein umfassenderes und informativeres Bild von L2-Entwicklung zu vermitteln, das wiederum sowohl aus theoretischer als auch aus praktischer (didaktischer/diagnostischer) Perspektive hochrelevant sein kann.

Außerhalb der PT spielt in gebrauchsbasierten Ansätzen der L2-Forschung, oft im sogenannten CAF-Framework (complexity, accuracy, fluency; vgl. etwa Housen / Kuiken / Vedder 2012), die sprachliche Komplexität derzeit eine prominente Rolle, und zwar in dreierlei Ausrichtung (vgl. Ortega 2012). Erstens wird die Komplexität häufig in Zusammenhang mit der Sprachkompetenz gebracht, etwa ausgedrückt durch GER-Niveaus, um ihre Eignung als Maß ebendieser zu beurteilen. Zweitens interessiert im Bereich aufgabenbasierten Lehrens und Lernens die Frage der Auswirkungen verschiedener Aufgabeneigenschaften auf die Komplexität lernersprachlicher Produktionen. Drittens wird versucht, die Komplexität in Zusammenhang mit der sprachlichen Entwicklung zu bringen, insbesondere mit dem Grammatikerwerb, also zu untersuchen, wie sich die sprachliche Komplexität im Erwerbsverlauf ändert. Im DAKODA-Kontext sind alle drei Ansätze relevant.

Die Komplexität spielt nicht nur in der L2-Erwerbsforschung, sondern auch in typologischen, kontaktlinguistischen und soziolinguistischen Forschungskontexten in diachroner wie synchroner Perspektive eine wichtige Rolle (vgl. Miestamo 2008; Kortmann / Szmrecsanyi 2012) und wird dementsprechend unterschiedlich definiert. In der L2-Komplexitätsforschung werden die anderen o.g. Forschungsstränge (leider) häufig ignoriert (vgl. Housen et al. 2019: 7). Hier sind die Definition und das an dieser Stelle nicht angeführte Modell von Bulté und Housen (2012) üblich:

at the most basic level, complexity refers to a property or quality of a phenomenon or entity in terms of (1) the number and the nature of the discrete components that the entity consists of, and (2) the number and the nature of the relationships between the constituent components. (Bulté / Housen 2012: 22)

Diese Definition betrifft die sogenannte ‚absolute Komplexität‘, für deren Definition gute linguistische Modelle vonnöten sind. Davon ist die ‚relative Komplexität‘ (auch: kognitive Komplexität oder Schwierigkeit) zu differenzieren. Diese bezieht sich darauf, wie schwierig oder aufwändig sprachliche Strukturen durch Sprecher:innen zu verarbeiten und zu internalisieren sind (vgl. Bulté / Housen 2012: 23-24; vgl. auch Housen / Simoens 2016). Absolut komplexe Strukturen müssen also nicht unbedingt auch schwierig zu lernen sein. Für L2-Lernende lässt sich relative Komplexität fassen als

the degree to which a language or language variety (or some aspect of a language or language variety) is difficult to acquire for adult language learners. (Kortmann / Szmrecsanyi 2012: 13)

Die relative Komplexität ist lerntheoretisch hochrelevant. Sie hängt u.a. mit der Salienz von sprachlichen Strukturen zusammen, die wiederum eine Funktion ihrer Inputhäufigkeit, ihrer absoluten linguistischen Komplexität und anderer Faktoren ist. Auch subjektive Aspekte wie etwa die Motivation, kognitive Faktoren usw. beeinflussen die relative Komplexität.

Kortmann / Szmrecsanyi (2012: 11) siedeln zwischen absoluter und relativer Komplexität die ‚redundanzinduzierte Komplexität‘ an. Zu dieser gehören überspezifizierte sprachliche Phänomene ohne synchron erkennbare Funktion wie etwa V2, syntaktische Asymmetrien zwischen Hauptsatz und Nebensatz, Genusmarkierung und andere. Ein anderes Konzept zwischen relativer und absoluter Komplexität ist die ‚irregulariätsinduzierte Komplexität‘, womit nicht-transparente unregelmäßige Flexions- und Wortbildungsprodukte gemeint sind. Für beide Typen ist eine theoriebasierte Perspektive (absolute Komplexität) zur Beschreibung nötig, während sie gleichzeitig Auswirkungen auf die Verarbeitungsschwierigkeit (relative Komplexität) haben. Deshalb sind sie potenziell auch für die L2-Forschung relevant, wurden aber hier unseres Wissens noch nicht fruchtbar gemacht.

Häufig werden der L2-Komplexitätsforschung mangelnde theoretische Fundierung sowie eine uneinheitliche Terminologie vorgeworfen (vgl. Ortega 2012; Szmrecsanyi 2015; Housen et al. 2019). Pallotti (2015) schlägt deshalb vor, sich eines klaren und einfachen Komplexitätsbegriffs zu bedienen. So wichtig wie anspruchsvoll ist dabei die Abgrenzung zwischen relativer und absoluter Komplexität:

In L2 research, relative and absolute complexity are often conflated, leading to tautological statements (e.g. ‘an (absolute) complex structure is a structure which is (relatively) complex (or: difficult)’) and to circular argumentation (e.g. when ‘complex L2 features’ are defined as ‘features that are acquired late’ while at the same time the late acquisition of a particular L2 feature is explained by its complexity). (Housen et al. 2019: 35)

Komplexität lässt sich auf allen linguistischen Ebenen messen (syntaktische, morphologische, lexikalische, phonologische, pragmatische, phraseologische Komplexität usw.), und zwar auf je sehr unterschiedliche Weise. Die meisten L2-relevanten Maße operationalisieren die Elaboriertheit von Strukturen. Syntaktische Komplexität, die hier besonders interessiert und auch am intensivsten beforscht ist, bezieht sich auf verschiedene syntaktische Einheiten (z.B. Phrasen, Clauses, Sätze) und kann sich in deren variierendem inneren Aufbau sowie Länge, subordinierender Einbettung im Satz oder koordinierender Verkettung zeigen.

Bereits 2009 schlagen Norris und Ortega vor, globale Komplexitätsindikatoren (bspw. die durchschnittliche Länge verschiedener linguistischer Einheiten), Koordinations- und Subordinationsmaße sowie spezifischere phrasale Komplexitätsmaße zu kombinieren. Zunehmend wird auch die Diversität (syntaktischer) Strukturen berücksichtigt, also das ganze Spektrum einem/einer Lernenden zur Verfügung stehender sprachlicher Mittel (vgl. Bulté / Housen 2018). Mittlerweile existiert eine enorme Bandbreite an Komplexitätsmaßen. In den letzten Jahren haben sich zudem die technischen Möglichkeiten zu deren automatisierter Analyse rasant verbessert, auch wenn die Genauigkeit solcher Analysen schwankt. Computerlinguistische Studien legen oft mehrere hundert verschiedene Komplexitätsmaße an. Für das Deutsche wurden diese teils auf dem Lernerkorpus MERLIN erprobt (vgl. Hancke 2013; Weiss 2017; Weiss / Meurers 2019) oder in anderen L1- oder L2-Studien genauer untersucht (vgl. Weiss et al. 2021; Weiss / Meurers 2021; Weiss et al. 2022)23. Die Common Text Analysis Platform (vgl. Chen / Meurers 2016) ermöglicht browserbasiert die Analyse dieser Komplexitätsmaße auch für eigene Korpora.

Szmrecsanyi (2015: 350-356) beurteilt die im L2-Bereich (zu diesem Zeitpunkt) üblichen Komplexitätsmaße aber kritisch und schlägt drei alternative Komplexitätstypen vor. Erstens sind das wohl v.a. in sprachvergleichender Perspektive relevante ‚typologische Profile‘, wobei analytische Elemente als weniger komplex, synthetische als komplexer gelten. Ein entsprechendes Maß erfasst den normalisierten Anteil freier grammatischer Marker (Flexionswörter) an allen Wörtern im Text. Zweitens schlägt er die ‚Kolmogorov-Komplexität‘ vor. Dieser informationstheoretische Komplexitätstyp operationalisiert die Länge der kürzestmöglichen Beschreibung eines Texts. Technisch werden dazu Textdateien komprimiert; leichter komprimierbare (besser vorhersagbare) Texte sind weniger komplex (vgl. Szmrecsanyi 2015: 353). Schließlich misst die ‚Variationskomplexität‘ die Anzahl der Beschränkungen für ein sprachliches Phänomen (die dafür natürlich sehr genau bekannt sein müssen). Damit spiegelt sie die Komplexität linguistischer Entscheidungsfindung (vgl. Szmrecsanyi 2015: 356). Hier liegen mehrere Studien zur Dativ- und Genitivalternation im Englischen (als L2) vor (z.B. Dubois et al. 2022). Analytizitätsmarker, die Kolmogorov-Komplexität und auch die Variationskomplexität können für den L2-Bereich unseres Erachtens durchaus fruchtbar gemacht werden.

Die sehr umfassende Forschung zur L2-Komplexität lässt sich an dieser Stelle nur grob vereinfachend zusammenfassen (vgl. zur Übersicht Ortega 2003; Housen et al. 2019; Kuiken et al. 2019). Die allermeisten Studien liegen zum Englischen als L2 vor und betreffen die syntaktische, in letzter Zeit zunehmend aber auch die morphologische Komplexität (z.B. Brezina / Pallotti 2019), kaum aber die phonologische. Crosslinguistische Perspektiven werden weitgehend vernachlässigt (also z.B. die Frage danach, ob bestimmte Phänomene in Ausgangssprache(n) und Zielsprache vergleichbar komplex sind, vgl. Housen 2019: 11). Insgesamt liegen einige klare, aber auch viele uneindeutige Befunde zur syntaktischen Kompetenz vor (vgl. Kuiken et al. 2019: 163). Häufig zeigen sich bezüglich globaler Komplexitätsmaße (z.B. Länge syntaktischer Einheiten, Subordinationsraten, Anzahl von Nebensätzen/Satz) lineare Trends, bezüglich spezifischerer Maße (z.B. Nebensatztypen/Nebensatz; Attributarten in der NP) aber komplexere Entwicklungsmuster (vgl. Housen et al. 2019: 9). Gleichzeitig erweist sich die Aussagekraft globaler Komplexitätsmaße allein als beschränkt (vgl. für das Deutsche Vyatkina et al. 2015).

Relativ klar ist, dass Lernende im Erwerbsverlauf zunächst zunehmend subordinierend schreiben bzw. sprechen (zunehmende clause-Komplexität), der Anteil an Subordination aber dann stagniert. Im beginnenden Bereich wächst zudem die Satzlänge an. Weniger eindeutige Befunde liegen zu koordinierenden Strukturen vor, die aber eher bei beginnenden Lernenden häufig zu sein scheinen, während komplexere koordinierende Strukturen auch von fortgeschrittenen Lernenden relativ selten gebraucht werden (vgl. für Deutsch als L2 hier Vyatkina 2012, 2013; Neary-Sundqvist 2016; Breindl 2023). Um Entwicklungsprozesse fortgeschrittener Lernender zu erfassen, eignet sich ein Fokus auf den Komplexitätsausbau innerhalb von Phrasen (vgl. Norris / Ortega 2009; Kuiken / Vedder 2019; Gamper 2022), aber auch Diversitätsmaße, die das Spektrum unterschiedlicher Strukturen erfassen, die Lernenden je zur Verfügung stehen, sind vielversprechend (vgl. z.B. Bulté / Housen 2018; für das Deutsche Lecouvet 2021).

Zum Deutschen finden Vyatkina et al. (2015) in ihrer auf einem Wortartentagging basierenden Analyse der Attribution im longitudinalen DaF-Korpus KANDEL (vgl. Vyatkina 2016) zwar sehr viel intra- und interindividuelle Variation, aber auch klare Entwicklungslinien bezüglich spezifischer Komplexitätsindikatoren. So nutzten z.B. beginnende Lernende vornehmlich prädikative, später mehr attributive Adjektive. Lecouvet (2021) schlägt als spezifisches Komplexitätsmaß für fortgeschrittene Lernende Aspekte nicht-kanonischer Wortstellung vor (Argumentposition in Passivsätzen und Konstituentenumstellung bei Topikalisierung, Scrambling und Linksdislokationen). Hancke und Meurers (2013) untersuchen Zusammenhänge von GER-Niveaus mit der lernersprachlichen Komplexität im MERLIN-Korpus computerlinguistisch. Bei sehr hoher Variabilität sind in dieser Studie lexikalische und morphologische Maße aussagekräftiger als syntaktische. Weiss / Meurers (2019) erweitern diesen Ansatz u.a. um sogenannte Sprachgebrauchsmaße (z.B. beruhend auf lexikalischen Frequenzinformationen aus Vergleichskorpora) und verarbeitungsbasierte Maße (z.B. bezogen auf den cognitive load). Mit insgesamt ca. 400 Maßen konnten die GER-Niveaus A2-B2 recht zuverlässig vorhergesagt werden (vgl. auch Weiss 2017). Besondere Aufmerksamkeit hat für das Deutsche der Erwerb komplexer Nominalphrasen erfahren, bislang weniger spezifisch im L2-Bereich als im Kontext von Studien zum literaten Sprachausbau bei Schülerinnen und Schülern in bildungssprachlichen Kontexten (vgl. z.B. Bast 2003; Petersen 2014; Gamper 2022). Die Nominalphrasenkomplexität wird dabei als eine Art Stellvertretermaß für Bildungssprachlichkeit verstanden. Schellhardt / Schroeder (2016) entwickeln in ihrer auf dem Lernerkorpus MULTILIT basierenden Analyse eine sukzessiv informationsverdichtende Hierarchie von NP; Weiss et al. (2022) untersuchen die Komplexität gesprochener Sprache im Unterricht mit computerlinguistischen Methoden.

Viele CAF-Studien verweisen darüber hinaus auf große sprachliche Variabilität in Abhängigkeit der vorliegenden Mehrsprachigkeitskonstellationen (z.B. Shadrova et al. 2022), Register (vgl. z.B. Biber et al. 2016), Aufgabenstellungen (vgl. Abrams / Rott 2017; Alexopoulou et al. 2017; Weiss 2017), Themen (vgl. z.B. Yoon 2017) und anderen Faktoren. Insgesamt ist zudem festzustellen, dass Studien zum Deutschen als L2 noch rar sind. Auch ist Pallotti zuzustimmen, der kritisch konstatiert, dass Komplexitätsmaße im L2-Bereich meist mangelhaft theoretisch motiviert und eingebettet seien und unter Missachtung von Konstruktvaliditätsfragen angewandt würden (vgl. Pallotti 2015: 118).

Komplexitätsmaße wurden unseres Wissens mit Ausnahme einer Studie von Norrby / Håkansson (2007) bis heute noch nicht systematisch in Zusammenhang mit PT-Stufen gebracht. Es ist offen, ob es hier unter Umständen zu komplexen Interaktionen und Trade-off-Effekten kommen könnte. Pienemann (1998: 87) hält die Verarbeitungskomplexität (processing complexity), die vielleicht einem Aspekt des heutigen Verständnisses von relativer Komplexität angenähert werden könnte, nicht für PT-relevant. Es gehe bei der PT-Verarbeitungshierarchie nämlich nicht um den kognitiven Aufwand bei der Verarbeitung, sondern vielmehr um das Vorhandensein der je genau passenden Verarbeitungsprozeduren. Dafür spiele der Verarbeitungsaufwand keine Rolle24. Norrby / Håkansson (2007, N = 4) setzen PT-Stufen und einige Komplexitätsmaße (u.a. Satzlänge, Subordinationsrate, Nominalquotient, NP-Typen) ins Verhältnis, und zwar für das Schwedische als L2. Sie finden einen negativen Zusammenhang von VEND mit Subordinationsmaßen, was sie damit erklären, dass Lernende zwar zunehmend Nebensätze nutzen, aber nicht die dafür verlangte Wortstellung (vgl. Norrby / Håkansson 2007: 61-62). Sie versuchen ferner, eine Typologie herauszuarbeiten, was den Umgang mit Komplexität im Verhältnis zur erreichten Erwerbsstufe angeht. Wegen des sehr geringen Stichprobenumfangs müssen die Befunde u.E. aber vorsichtig interpretiert werden.

Bereits 1998 formulierte Pienemann die sogenannte steadiness hypothesis, nach der Aufgabenformate keinen wesentlichen Einfluss auf den in Lernersprache nachzuweisenden Stufenstatus haben, solange ausreichend Sprache in kommunikativen Formaten produziert wird (vgl. Pienemann 1998: 273-307). Dies würde den starken Aufgabeneffekten, die in der Komplexitätsforschung gefunden werden, widersprechen. Kawaguchi und Ma (2019) untersuchen 30 Englischlernende auf drei Kompetenzniveaus und hinsichtlich zweier Aufgaben, die sich in der Planungszeit unterscheiden. Sie kommen zu dem Schluss, dass die Erwerbsstufen unabhängig von der kognitiven Aufgabenkomplexität konstant beobachtbar waren, während Korrektheitsmaße zu weniger stabilen Ergebnissen über die Aufgaben hinweg führten, vor allem bei schwächeren Lernenden. Allerdings sind diese Ergebnisse unseres Erachtens wegen eines Problems statistischer Teststärke (30 Lernende, 2 Aufgaben*3 Kompetenzniveaus) zurückhaltend zu interpretieren. Yamaguchi / Kawaguchi (2022) vergleichen zwei Aufgaben (Erzählen, N = 88; Bildbeschreibung, N = 51) aus zwei Korpora Englischlernender mit japanischer L1. In beiden Gruppen finden die Autor:innen die PT-typische Erwerbssequenz. Allerdings erlaubt das Studiendesign nicht zu beurteilen, inwiefern verschiedene Aufgaben bei denselben Lernenden zu unterschiedlichen Befunden hätten führen können. Ehl et al. (2018) demgegenüber zeigen in ihrer umfassenderen Validierungsstudie der Profilanalyse starke Aufgabeneffekte. Allerdings weicht die praxisorientiertere Profilanalyse sowohl in der Stufendefinition als auch in den genutzten Emergenzkriterien von den Verfahren der PT ab, sodass dieser Befund die steadiness hypothesis nur indirekt tangiert.

Studien, die methodisch angemessen und theoretisch fundiert sowohl die Erwerbsstufen als auch Komplexitätsmaße für die L2 Deutsch zur Anwendung bringen, fehlen noch gänzlich. Deshalb sollen auch in DAKODA „automatische“ Komplexitätsanalysen durchgeführt werden.

2.5 Sprachkompetenzniveaus des GER

Der Gemeinsame europäische Referenzrahmen für Sprachen mit seinem Begleitband (vgl. Europarat 2001, 2020) muss in einer DaF-/DaZ-Zeitschrift wohl kaum umfassend eingeführt werden. Wir konstatieren deshalb hier lediglich erneut die unbestreitbare Wirkmacht der GER-Niveaus, die gleichzeitig oft aus verschiedenen, teils guten Gründen auch kritisiert werden. Frappierend ist allerdings die Tatsache, dass trotz ihrer enorm weiten Verbreitung bislang für das Deutsche (anders als für das Englische, vgl. das English Profile Project, Hawkins / Filipović 2012) weitgehend unbekannt ist, welche sprachlichen Strukturen auf den einzelnen GER-Niveaus typischerweise auftreten. Während für das Englische sogenannte Referenzniveaubeschreibungen vorliegen, die grammatische Strukturen und Wortschatz basierend auf einem sehr großen Lernerkorpus empirisch robust an die GER-Niveaus knüpfen, ist für das Deutsche mit Profile deutsch (vgl. Glaboniat et al. 2005) weiterhin lediglich eine expert:innenbasierte Sammlung an sprachspezifischen Konkretisierungen der Deskriptoren verfügbar. Genauer zu verstehen, wie Lernende auf den verschiedenen Niveaus sprachlich handeln, ist deshalb ein wichtiges Desiderat der L2-Forschung.