1. Einleitung

Korpora gesprochener Sprache bieten Forschenden, Lernenden und Lehrenden eine Vielzahl an unterschiedlichen Nutzungsmöglichkeiten. Diese können dabei deutlich über die Funktionalitäten geschriebener Korpora hinausgehen.

Für ein Korpus geschriebener Sprache sind automatische Suchabfragen (‚Queries‘) der primäre und oft einzige Zugangsweg. Mit solchen Abfragen werden Vorkommen eines zu untersuchenden Phänomens, ggf. mit einer kleinen Menge Kontext und zugehörigen Metadaten, ausgewählt. Diese Vorkommen können dann quantifiziert oder in anderer Weise weiter ausgewertet werden. Weil es in der Korpuslinguistik geschriebener Sprache bislang eher unüblich (und für viele Arten von Analysen auch nicht notwendig) ist, eine Analyse statt von einer Suchabfrage von einem einzelnen Text ausgehen zu lassen, wird einer umfassenderen Rekontextualisierung von Suchergebnissen, also deren Inbezugsetzung zu vorausgehendem und folgendem sprachlichen Material oder zu Eigenschaften des Textes oder des/der Autor:in, oft wenig Beachtung geschenkt1.

Für viele Arten von Arbeit mit gesprochener Sprache ist dies grundlegend anders. Zwar wird auch jede Korpusplattform für diesen Datentyp die Funktionalität für Suchabfragen beinhalten. Zusätzlich sind aber ein eingehendes und detailliertes Studium (‚Lesen‘) des Transkripts und der Rückgriff auf die zugrunde liegenden Audio- oder Videoaufnahmen viel häufiger essentielle und unabdingbare Schritte in der Analyse. Der Wert eines mündlichen Korpus hängt somit stark davon ab, welche Zugangsmöglichkeiten für den Zugriff auf und die Exploration von Transkripten zur Verfügung stehen. Bisherige Studien zur Nutzung mündlicher Korpora zeigen, dass Nutzer:innen Zugriff auf Transkripte und Audio bzw. Video benötigen,

- um sich mit den Korpusdaten vertraut zu machen, d.h. um eine Vorstellung von der Beschaffenheit der aufgezeichneten Interaktionen, eine Vorstellung von Art und Qualität der Transkription zu bekommen u.Ä.;

- um auf Sequenzen im Transkript qualitative Analysen auszuführen. Diese Sequenzen können durch eine vorangehende systematische Query identifiziert worden sein, aber sie können auch ‚manuell‘, also beim Durchsehen des gesamten Transkripts gefunden worden sein. Letzteres wird in Disziplinen wie der Konversationsanalyse oft die bevorzugte Vorgehensweise sein;

- um einzelne Query-Ergebnisse auszuwerten, etwa mehrdeutige Formen zu disambiguieren, falsche Positive auszusortieren u.Ä. Dies erfordert oft einen Rückgriff auf den größeren Transkriptkontext und/oder auf das zugrunde liegende Audio oder Video;

- um Transkript- und/oder Aufnahmeausschnitte auf den eigenen Rechner herunterzuladen, z.B. um sie dort mit Hilfe einer spezialisierten Software wie Praat (vgl. Boersma 2001) hinsichtlich akustischer Merkmale zu analysieren;

- für verschiedenste Präsentationszwecke, die von der Integration eines gedruckten Transkripts in eine Publikation über die Einbettung eines Ausschnitts in eine Präsentation bis zum Zusammenstellen von Beispielkollektionen, die für Lehrzwecke genutzt werden, reichen. Letzteres ist von besonderer Relevanz für Sprachlehrkräfte, die wir als wichtigste Nutzergruppe von ZuMult im Blick haben (siehe hierzu Schmidt et. al. 2023 in dieser Themenausgabe).

In einer digitalen Umgebung kann ein ‚Transkript‘ viel mehr sein als nur ein Dokument, das schriftlich wiedergibt, was im Audio- oder Videomaterial zu hören oder zu sehen ist (vgl. Schmidt 2005 und 2010). Wenn die Transkription in einer geeigneten Datenstruktur modelliert ist, kann eine Bildschirmdarstellung des Transkripts eine Vielzahl von Funktionen ermöglichen, die für die oben genannten Aufgaben nützlich sind, z.B. die Wiedergabe der Aufnahme mit synchronisierter Hervorhebung der betreffenden Stelle im Transkript, die optionale Anzeige von Annotationen, die Integration von Sprecher- oder Kommunikations-Metadaten und so weiter.

Die Herausforderung besteht dabei nicht so sehr darin, das eigentliche Transkript mit zusätzlichen Informationen anzureichern, sondern es so zu präsentieren, dass alle und nur die für einen bestimmten Nutzungskontext relevanten Informationen angezeigt werden, und die Nutzer:innen entscheiden zu lassen, was relevant ist und was nicht. Das Transkript wird so zu einer Art interaktiver Visualisierung.

Das im ZuMult-Projekt entwickelte Tool ZuViel (Zugang zu Visualisierungselementen für Transkripte) ist der Versuch einer solchen Visualisierung, die darauf abzielt, das Transkript leicht lesbar zu machen, und die von den Nutzer:innen so konfiguriert werden kann, dass bestimmte Arten von Informationen entsprechend dem jeweiligen Nutzungskontext einbezogen, ausgeschlossen oder hervorgehoben werden. Sie basiert auf der ZuMult-Spezifikation der ISO/TEI-Normen für Transkriptionen und verwendet die ZuMult-Basisarchitektur (vgl. Schmidt et. al. 2023 in dieser Themenausgabe).

Im vorliegenden Beitrag werden die in ZuViel integrierten Funktionalitäten vorgestellt. Nach einem kurzen Überblick über die in einem FOLK- oder GeWiss-Transkript enthaltenen Informationen (Abschnitt 2) werden die Visualisierungsoptionen in ZuViel sowie Möglichkeiten zur Interaktion mit dem Transkript (Abschnitt 3) erläutert. Daran anschließend gehen wir auf Anwendungsperspektiven ein, die sich für Nutzer:innen von ZuViel in didaktischen und forschungsbezogenen Kontexten eröffnen (Abschnitt 4).

2. Information im Transkript

Da ZuViel Zugang zu so vielen verschiedenen Arten von Informationen bietet, soll hier zunächst kurz rekapituliert werden, welche Informationen ein Transkript (in den Korpora FOLK und GeWiss) enthält:

- den transkribierten Text in literarischer Transkription;

- eine Segmentierung des Textes in Sprecherbeiträge;

- eine Zuordnung jedes Sprecherbeitrags zu einer Sprecherin oder einem Sprecher;

- eine Zuordnung von (Teilen von) Sprecherbeiträgen zu einem Abschnitt in der Audio- oder Videoaufnahme (‚Alignment‘);

- eine Tokenisierung (Unterteilung) des Textes in Wörter und nonverbale Tokens (wie Pausen, Atmung, nonverbale Handlungen wie Lachen); dabei wird jedem Token eine eindeutige ID zugeordnet, so dass es sich z.B. für eine Hervorhebung oder eine Standoff-Annotation adressieren lässt;

-

- eine Annotation jedes Tokens mit:

- einer normalisierten Form, d.h. dem orthografischen Standardäquivalent der transkribierten Form in der literarischen Transkription (z.B. zwei für zwo oder hast Du es für hastes) (vgl. Winterscheid et al. 2019);

- einem Lemma, d.h. der Grundform von flektierten Formen (z.B. gehen für gehst oder Haus für Häuser);

- einem Part-of-Speech-Tag (z.B. VVFIN = Finites Vollverb für gehst) (vgl. Westpfahl 2020);

- einer phonetische Annotation in IPA (wie ɡeːʃt für gescht), einschließlich der Syllabifizierung, d.h. der Aufteilung einer Wortform in Silben (wie ɡeː.ən für gehen, wobei der Punkt die Silbengrenze repräsentiert);

-

- verschiedene aus den vorgenannten Informationen abgeleitete Maße (siehe hierzu Fandrych / Meißner / Schwendemann / Wallner in dieser Themenausgabe), insbesondere:

- die Sprechgeschwindigkeit eines Beitrags, berechnet als Anzahl der Silben pro Sekunde, d.h. unter Verwendung der phonetischen Annotation und der zeitlichen Ausrichtung der Äußerungen;

- die Normalisierungsrate eines Beitrags, berechnet als der Anteil der Token, deren normalisierte Form von der transkribierten Form abweicht;

- (im Fall von GeWiss) zusätzliche (partielle) manuelle Annotationen zu Sprachwechseln, zu Diskurskommentierungen sowie zu Zitationen und Verweisen (vgl. Fandrych / Meißner / Wallner 2017);

- (im Fall von FOLK) zusätzliche (partielle) manuelle Annotationen zu Themen und Handlungssequenzen (siehe Kaiser 2023 in dieser Themenausgabe);

- Verweise auf umfassende Metadaten zum Gespräch selbst und zu den daran beteiligten Sprecher:innen.

3. Visualisierungen in ZuViel

In diesem Abschnitt stellen wir nacheinander dar, aus welchen Elementen die Visualisierung in ZuViel besteht (Abschnitt 3.1), wie Nutzer:innen in diesen Elementen navigieren können (Abschnitt 3.2) und welche Möglichkeiten ZuViel bietet, die Visualisierungselemente zu konfigurieren und anzupassen (Abschnitte 3.3 und 3.4).

3.1 Elemente der Visualisierung

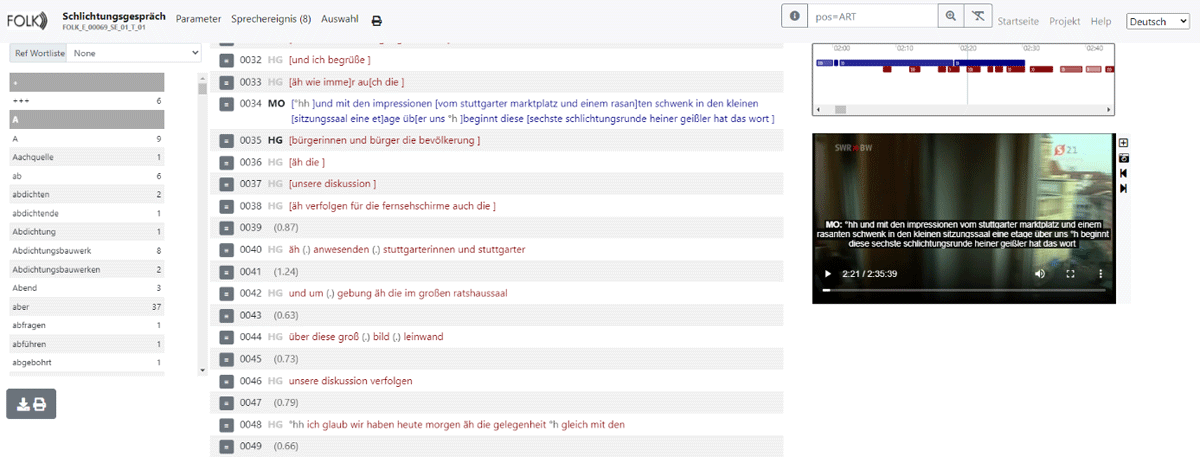

Die Transkriptanzeige von ZuViel ist in drei Spalten gegliedert (vgl. Abbildung 1). Die mittlere Spalte ist die größte und enthält das eigentliche Transkript. Die linke Spalte ist für die konfigurierbare Anzeige einer Wortliste reserviert, die rechte Spalte enthält einen sogenannten Density Viewer und einen Player für die zum Transkript gehörende(n) Audio- oder Videoaufnahme(n). Am oberen Rand der Seite finden Nutzer:innen ein Menü mit verschiedenen Funktionen zur Einstellung der Transkriptparameter und zur Interaktion mit einer Auswahl des Transkripts.

Technisch werden alle Komponenten mit Hilfe des Bootstrap-Frameworks realisiert. Dies ist eine Lösung für die Gestaltung von Webseiten, bei der viele Aspekte bereits professionell auf Benutzerfreundlichkeit optimiert wurden. Die Tatsache, dass Bootstrap auch in vielen anderen Webanwendungen eingesetzt wird, macht das ‚Look & Feel‘ von ZuViel für viele Nutzer:innen vertraut.

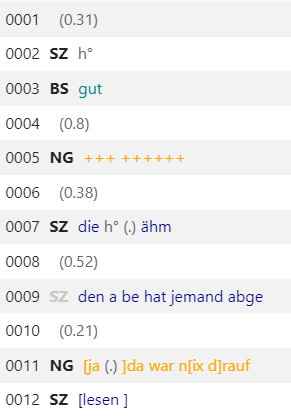

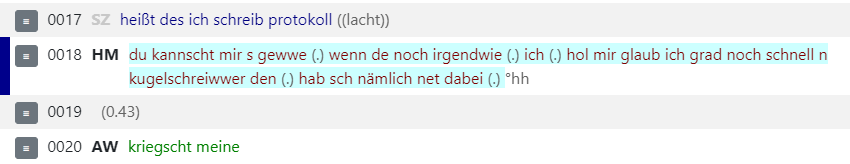

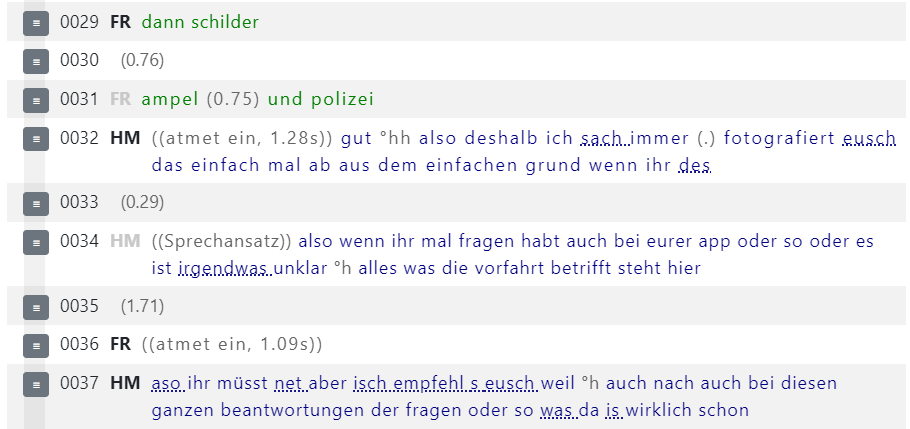

Als Basisdarstellung in ZuViel werden die (literarisch) transkribierten Formen ausgewählt und in einer zeilenweisen Notation dargestellt, wobei eine Zeile einem Sprecherbeitrag entspricht und die Sprecherzuordnung über ein Sprecherkürzel und durch unterschiedliche Schriftfarben für verschiedene Sprecher angezeigt wird (vgl. Abbildung 2).

Ein Doppelklick auf eine beliebige Stelle in der Transkription startet die Audio- oder Videowiedergabe an der entsprechenden Stelle der Aufnahme. Die aktuelle Position der Wiedergabe wird im Transkript durch einen dunkelblauen Balken links neben dem/den Sprecher(n) und durch einen hellblauen Hintergrund des transkribierten Textes selbst hervorgehoben (vgl. Abbildung 3).

Während das Transkript auf diese Weise genutzt werden kann, um bestimmte Stellen in der/den Audio- bzw. Videoaufnahme(n) anzusteuern, ist es auch möglich, andersherum zu navigieren, d.h. eine Stelle in der Aufnahme auszuwählen, um zu dem entsprechenden Teil des Transkripts zu gelangen.

In der Standardeinstellung und wenn die zugrundeliegende Aufnahme ein Video ist, wird der Transkripttext auch als Untertitel auf dem Videobild angezeigt (vgl. Abbildung 4).

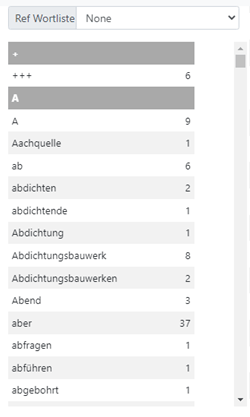

Die Wortliste auf der linken Seite listet standardmäßig alle im Transkript vorkommenden Lemmata mit ihren Häufigkeiten auf (vgl. Abbildung 5). Wenn man eine Referenzwortliste auswählt, lassen sich alle Formen markieren, die sowohl Teil dieser Referenzwortliste sind als auch im Transkript vorkommen. Durch einen Doppelklick auf einen Eintrag in der Wortliste wird die erste entsprechende Form im Transkript angezeigt und hervorgehoben (und weitere Formen bei weiteren Doppelklicks).

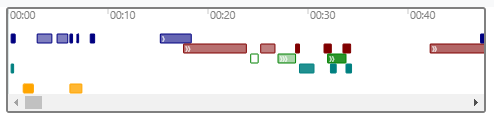

Der Density Viewer in der oberen rechten Ecke visualisiert die Struktur der Interaktion, indem er jeden Sprecherbeitrag als Balken darstellt, dessen Länge der Dauer und dessen Position der zeitlichen Zuordnung entspricht (vgl. Abbildung 6). Auf diese Weise ist es auf einfache Weise möglich, stark interaktive Passagen von eher monologischen zu unterscheiden. Als zusätzliche Information gibt die Einfärbung der Balken einen Hinweis auf den Sprecher und den Normalisierungsgrad des jeweiligen Beitrags: je ‚gesättigter‘ die Farbe, desto höher der Anteil standardkonformer Formen, die er enthält. Die Anzahl der spitzen Klammern innerhalb der Balken schließlich entspricht der Sprechgeschwindigkeit des jeweiligen Beitrags – eine Klammer für deutlich langsameres Sprechen als der Durchschnitt, drei für deutlich schnelleres Sprechen.

Der Density Viewer ist ebenfalls mit dem Transkript und der Audio-/Videowiedergabe synchronisiert, so dass er zur Navigation zu den jeweiligen Positionen verwendet werden kann und die aktuelle Abspielposition durch einen Cursor angezeigt wird.

3.2 Navigation in der Visualisierung

Wie bereits oben skizziert, sind die verschiedenen Komponenten der Visualisierung alle synchronisiert, d.h. die Navigation (Scrollen, Auswählen, Anklicken etc.) in einer der Komponenten führt dazu, dass sich die anderen Komponenten entsprechend aktualisieren. In der Praxis kann dies wie folgt genutzt werden:

- Benutzer:innen können von jeder beliebigen Stelle im Transkript in die Aufzeichnung(en) springen;

- Der Teil des Transkripts, der dem gerade abgespielten Teil der Aufzeichnung entspricht, wird hervorgehoben;

- Beim Vor- oder Zurückspulen der Aufzeichnung blättert das Transkript zu dem entsprechenden Ausschnitt;

- Mit einem Doppelklick auf die Einträge in der Wortliste kann das Transkript an die Stelle(n) gescrollt werden, an denen das jeweilige Wort vorkommt. Dieses Wort wird dann hervorgehoben;

- Der Density Viewer kann verwendet werden, um Passagen mit bestimmten interaktiven Eigenschaften, z.B. viel oder wenig Interaktivität, schnell auszuwählen.

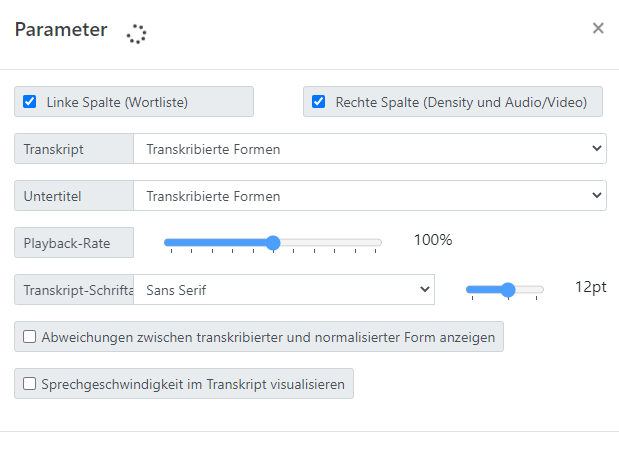

3.3 Parameter für die Visualisierung

Über das Parameter-Menü können Einzelheiten der Visualisierung angepasst werden (vgl. Abbildung 7). Die linke Spalte (mit der Wortliste) und/oder die rechte Spalte (mit dem Density Viewer und den Audio-/Video-Playern) können ausgeblendet werden, wenn sie nicht benötigt werden. So steht mehr Platz für das Transkript zur Verfügung, und der visuelle Gesamteindruck wird durch gerade nicht benötigte Informationen nicht gestört.

Die Anzeige von Untertiteln in den Videos kann nach Bedarf aus- oder eingeblendet werden. Sowohl für die Untertitel als auch für das Transkript selbst können Nutzer:innen wählen, ob sie die (in literarischer Umschrift) transkribierten Formen, die standardorthographisch normalisierten Formen, die phonetischen Formen oder auch Lemmata oder POS-Tags anzeigen möchten. Beispielsweise wird eine Anzeige der normalisierten Formen das Lesen und Verstehen des Transkripts (z.B. für Sprachlernende) erleichtern, die besonderen Eigenschaften der gesprochenen Sprache bleiben in dieser Anzeige jedoch ausgeblendet.

Ebenfalls zur Erleichterung des Verständnisses kann die Abspielgeschwindigkeit für Audio und Video verringert (oder wahlweise auch erhöht) werden. Die Grundfrequenz des Audios bleibt dabei weitestgehend erhalten. Dadurch stellt sich weder ein sogenannter ‚Micky-Mouse-Effekt‘ ein, wenn schneller abgespielt wird, noch werden die Stimmen bei langsamerem Abspielen tiefer.

Auf Wunsch können im Transkript auch diejenigen Formen hervorgehoben werden, bei denen sich transkribierte und normalisierte Form unterscheiden (wo also die Aussprache vom Standard abweicht, wie bei sach vs. sage in Abbildung 8, Zeile 0032), und die Sprechgeschwindigkeit kann durch unterschiedliche Laufweiten der Schriftart visualisiert werden (Zeile 0032 in Abbildung 8 visualisiert z.B. langsameres Sprechen).

Anzeige von Ausspracheabweichungen und Sprechgeschwindigkeit2

Schließlich lassen sich auch Schriftart und -größe für das Transkript an den jeweiligen Präsentationszweck oder individuelle Präferenzen anpassen.

3.4 Interaktion mit dem Transkript

Wir verstehen in ZuViel das Transkript als ein digitales Objekt, dass den Nutzer:innen (Lehrenden, Lernenden, Forschenden) nicht als statische Einheit präsentiert wird, sondern mit dem sie in vielfältiger Weise themengeleitet und -explorierend interagieren. Neben den basalen Rezeptionsmöglichkeiten des Lesens (Transkripts), Anhörens (Audio) und Ansehens (Videos) haben Nutzer:innen daher weitere Möglichkeiten, mit dem Transkript zu interagieren.

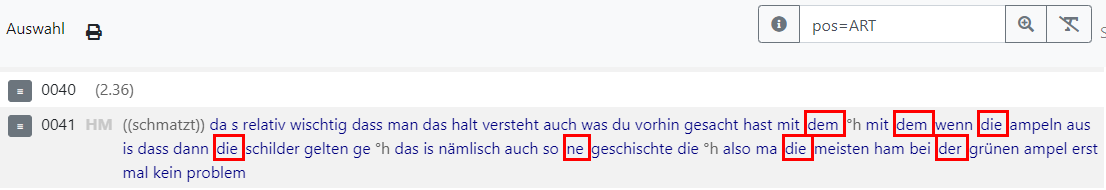

Beispielsweise können über die Wortlisten am linken Bildschirmrand oder ein Suchfeld rechts in der oberen Navigationsleiste ausgewählte Wortformen im Transkript hervorgehoben werden. Die Wortliste steuert transkribierte Wörter über ihre Lemmata an, so dass z.B. über die Sucheingabe „gehen“ alle konjugierten Formen des Verbs (gehst, ging, gegangen) im Transkript erreicht werden. Über die Suchbox ist eine einfache Abfrage auf allen Annotationsebenen möglich. Im abgebildeten Beispiel wurde etwa über den Suchausdruck „pos = ART“ nach allen Artikeln, also Wortformen mit dem POS-Tag ‚ART‘, im Transkript gesucht.

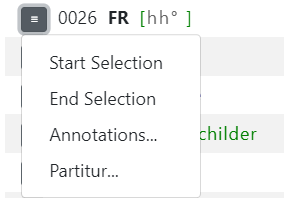

Wenn eine Transkriptzeile (ein Sprecherbeitrag) ausgewählt wurde, können über ein Kontextmenü zusätzliche Informationen (etwa verschiedene Annotationsebenen) und Visualisierungs-Elemente dazu in Popup-Fenstern (Abbildung 10 Kontextmenü für einen Beitrag) angezeigt werden.

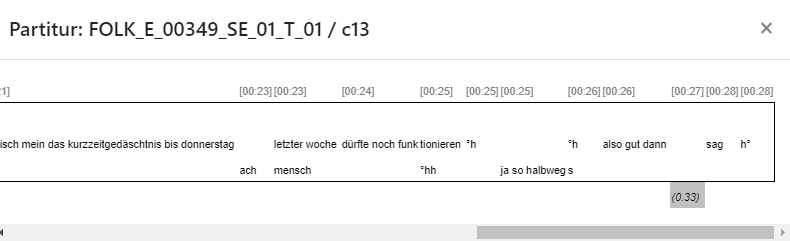

Eine Partituransicht visualisiert die zeitlichen Verhältnisse des Gesprächsverlaufs an der betreffenden Stelle und macht dadurch insbesondere Gleichzeitigkeit (Überlappungen, Rezeptionssignale) visuell schneller erfassbar:

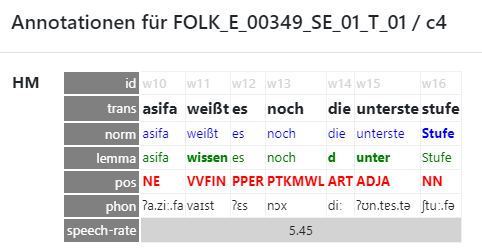

Eine weitere Ansicht zeigt alle zum Sprecherbeitrag gehörenden Annotationen (von oben nach unten für jedes Token: die Token-ID, die literarisch transkribierte Form, die orthographisch normalisierte Form, das Lemma, das POS-Tag, die phonetische Transkription; die Artikulationsrate für den gesamten Beitrag) an (vgl. Abbildung 12).

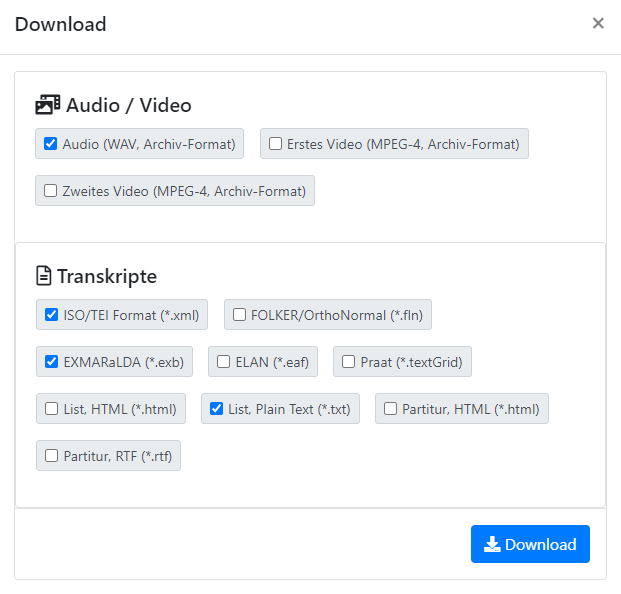

Der Einsatz von Transkripten in einem Lehr-/Lernszenario beinhaltet oft an zentraler Stelle die Auswahl geeigneter Transkriptausschnitte, die das behandelte Thema möglichst deutlich und kompakt illustrieren (vgl. Fandrych / Schwendemann / Wallner 2021). Nachdem unter Zuhilfenahme der bisher beschriebenen Methoden ein solcher Ausschnitt gefunden wurde, können Nutzer:innen diesen markieren, indem sie (über das Kontextmenü in Abbildung 10) die betreffende Start- und Endzeile im Transkript auswählen (vgl. Abbildung 13):

Ein so ausgewählter Ausschnitt kann zudem isoliert angezeigt werden, und es gibt die Möglichkeit, alle zugehörigen Daten in verschiedenen Formaten herunterzuladen (vgl. Abbildung 14). Dies ermöglicht die weitere Bearbeitung eines Transkriptausschnittes beispielsweise in Software-Tools wie EXMARaLDA (vgl. Schmidt / Wörner 2014), Praat oder ELAN (vgl. Sloetjes 2014) sowie das Ausdrucken oder die Integration eines Beispiels in ein Textverarbeitungsdokument etwa als Grundlage für die Erstellung von Lückentexten.

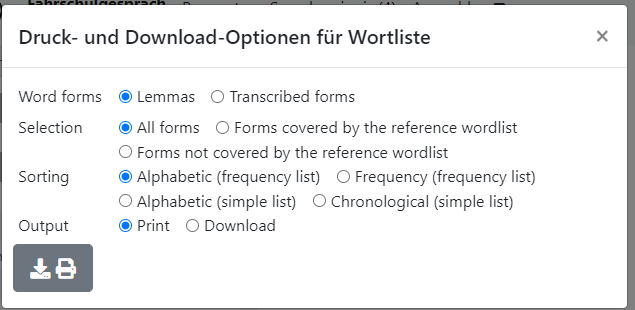

Darüber hinaus ist ein Download von Wortlisten möglich. Diese umfassen den gesamten in einem Transkript enthaltenen Wortschatz. Zur Auswahl stehen dabei eine Lemmaliste und eine Liste aller transkribierten Einheiten. Zudem besteht die Möglichkeit, den Download auf den durch eine ausgewählte Referenzwortliste gedeckten oder wahlweise auch nicht gedeckten Wortschatz zu beschränken.

4. Anwendungsperspektiven

Mit dem Transkriptbrowser ZuViel wurde eine Oberfläche geschaffen, die sowohl für didaktische Settings als auch für Forschungskontexte vielfältige neue Nutzungsmöglichkeiten mündlicher Korpusdaten eröffnet. In der Regel wird ZuViel weniger als eigenständige Komponente denn als Bestandteil anderer Anwendungen verwendet. Wie ZuViel in andere Zugangswege eingebettet ist, wird im Folgenden (Abschnitt 4.1) kurz erläutert. Daran anschließend wird gezeigt, wie ZuViel in didaktischen (Abschnitt 4.2) und in forschungsbezogenen Kontexten (Abschnitt 4.3) genutzt werden kann.

4.1 Zugangswege

Zunächst kann ZuViel über das Tool ZuMal (vgl. Fandrych et al. 2023 in dieser Themenausgabe) aufgerufen werden. Hier steht nach der Auswahl eines Sprechereignisses mit Hilfe verschiedener Auswahlfilter jeweils ein Link zur Verfügung, der das Transkript des ausgewählten Sprechereignisses in ZuViel öffnet. Ein weiterer, vorrangig didaktisch ausgerichteter Zugang zu ZuViel ergibt sich über ZuHand (vgl. Kaiser 2023 in dieser Themenausgabe), wobei dort Sprechereignisse zunächst nach Handlungssequenzen gefiltert und dann die entsprechend ausgewählten Transkripte bzw. Transkriptausschnitte in ZuViel geöffnet werden können. Darüber hinaus kann ZuViel auch über die Ergebnisliste von in ZuRecht durchgeführten Suchanfragen angesteuert werden (vgl. Frick / Helmer / Wallner 2023 in dieser Themenausgabe).

Je nach gewähltem Zugangsweg werden in ZuViel vollständige Transkripte oder Transkriptausschnitte angezeigt. Während es sich bei einem Zugang über ZuMal immer um vollständige Transkripte handelt, werden von ZuHand jeweils nur ausgewählte Transkriptausschnitte in ZuViel aufgerufen. Diese lassen sich jedoch bei Bedarf erweitern. Wird ZuViel über ZuRecht angesteuert, öffnet sich bei einer zuvor durchgeführten Konkordanzanalyse auch ein Transkriptausschnitt, der das in der Suchanfrage fokussierte Elemente enthält. Dieses wird zusätzlich rot umrahmt. Erfolgt in ZuRecht eine Suche mit Wortschatz- bzw. Querylisten3 (vgl. Frick / Helmer / Wallner 2023 in dieser Themenausgabe), wird wiederum das gesamte Transkript in ZuViel aufgerufen, und die in der Wortschatz- bzw. Queryliste enthaltenen Einheiten werden auch dann in ZuViel rot umrahmt.

4.2 Nutzung von ZuViel in didaktischen Kontexten

Das Anliegen von ZuViel ist es, einen insbesondere für sprachdidaktische Kontexte geeigneten Zugriff für die Exploration mündlicher Korpusdaten zu ermöglichen. Damit wird zunächst der Forderung nach der Bereitstellung authentischer mündlicher Kommunikation für Vermittlungskontexte Rechnung getragen. So wird vielfach beklagt, dass die Merkmale der Mündlichkeit in Lehrmaterialien häufig anhand einer an Schriftsprache orientierten Normvorstellung betrachtet werden und Beispiele für authentisches sprachliches Handeln fehlen (vgl. Günthner / Wegner / Weidner 2013). Zwar existieren inzwischen erste Vorschläge für die Einbeziehung authentischer Sprachbeispiele anhand der Didaktisierung von Transkriptausschnitten (vgl. z.B. Moraldo / Missaglia 2013; Imo / Weidner 2018). Eine systematische und an verschiedene Unterrichtsthemen und Vermittlungsbedarfe adaptierbare Thematisierung der Merkmale gesprochener Sprache war jedoch aufgrund der vergleichsweise komplizierten Zugriffswege bislang kaum möglich. Die Möglichkeit der Exploration authentischer mündlicher Sprachdaten für Lehr- und Lernzwecke eignet sich dabei besonders für die gebrauchsorientierten Sprachdidaktik, in deren Rahmen sprachliche Strukturen in ihren jeweiligen Kontexten und mit ihren jeweiligen Funktionen (und nicht etwa isoliert vom tatsächlichen Gebrauch bspw. in Form von Transformationsübungen) vermittelt werden. Daneben bieten sich damit auch vielfältige Möglichkeiten für das datengeleitete Lernen, bei dem sich Lernende selbstständig mit authentischen Daten der Sprachverwendung befassen und auf dieser Grundlage Gebrauchscharakteristika ableiten (vgl. u.a. Boulton 2009).

Da die in ZuViel implementierten Visualisierungs- und Interaktionsoptionen an Konzepten und Prinzipien der Sprachvermittlung sowie an lernerseitigen Informationsbedürfnissen ausgerichtet sind, eröffnen sich zudem weitere, über das reine Lesen und Abspielen von Sprechereignissen deutlich hinausgehende sprachdidaktische Nutzungsmöglichkeiten. Diese werden im Folgenden kurz skizziert.

Dem jeweiligen Zugangsweg entsprechend werden in ZuViel vollständige Transkripte oder Transkriptausschnitte angezeigt. Da viele der vollständigen Transkripte für didaktische Kontexte zu umfangreich sind, ist bereits vor der eigentlichen Arbeit mit einem Sprechereignis im Unterricht die Auswahl einer oder mehrerer Sequenzen erforderlich. Der Density Viewer bietet hier eine mögliche Unterstützung, da anhand der darin bereitgestellten Visualisierung des Sprechereignisses geeignete Sequenzen ermitteln werden können. Zu denken wäre hier bspw. an die Ermittlung von Sequenzen, die mehr oder weniger standardkonform sind und/oder keine bzw. nur wenige Überlappungen enthalten. Auch mit Hilfe der Wortschatzlisten lassen sich im Transkript geeignete Sequenzen identifizieren. So kann bspw. die A2 Wortschatzliste ausgewählt werden. Alle Wörter, die den Niveaustufen A1 und A2 angehören, werden dadurch im Transkript gelb unterlegt. Lehrende können auf diese Weise diejenigen Sequenzen schneller identifizieren, deren Wortschatzniveau dem ihrer Lernenden am besten entspricht. Mit Hilfe der Suchbox in der Menüzeile, welche für Abfragen auf allen Annotationsebenen genutzt werden kann, lassen sich ebenfalls geeignete Sequenzen ermitteln. Denkbar wäre hier beispielsweise, dass sämtliche Mündlichkeitsphänomene im Transkript abgefragt und damit rot umrahmt werden. Lehrende können auf dieser Grundlage wiederum Sequenzen auffinden, in denen Mündlichkeitsphänomene besonders gehäuft auftreten. Dieses Vorgehen bietet sich auch an, wenn ein längeres Transkript in ZuViel über eine zuvor in ZuRecht durchgeführte Suche mit Wortschatz- oder Query-Listen angesteuert wird (vgl. 4.1). Lehrende können somit diejenigen Sequenzen im Transkript, in denen die jeweils fokussierten Einheiten oder Phänomene häufig vorkommen, schneller identifizieren. Gerade in gebrauchsbasierten Ansätzen der Sprachvermittlung wird vielfach eine solche Inputoptimierung gefordert, um sicherzustellen, dass Lernende den im Fokus stehenden Phänomenen hinreichend oft begegnen (vgl. auch Amorocho-Duran / Pfeiffer im Druck).

Die auf diese Weise oder auch explorativ ermittelten Sequenzen können – wie oben bereits erläutert – isoliert in einem eigenen Browser-Tab angezeigt und dort gesondert didaktisch aufbereitet werden. Dabei kann es sich sowohl um längere Ausschnitte von mehreren Minuten als auch um sehr kurze Sequenzen handeln, die für sogenannte Mikro-Hörübungen genutzt werden (vgl. Dietz 2021).

Ebenfalls im Vorfeld der Arbeit mit einem Sprechereignis lässt sich mit Hilfe der Zertifikats-Wortschatzlisten derjenige Wortschatz eines Sprechereignisses identifizieren, der den Lernenden voraussichtlich unbekannt ist – etwa, weil er nicht zu dem einer Niveaustufe zugeordneten Wortschatz gehört. Lehrende haben so die Möglichkeit, den entsprechenden Wortschatz vorzuentlasten. Auch die für einige Sprechereignisse verfügbaren Videomitschnitte können die Vorentlastung unterstützen, indem Lernende bspw. anhand kurzer Sequenzen oder auch Screenshots den kontextuellen Rahmen und die Gesprächssituation identifizieren (Wo findet das Gespräch statt? Wer sind die Gesprächsteilnehmer:innen?).

Die im Abschnitt „Parameter der Visualisierung“ aufgeführten Einstellungsmöglichkeiten sind insbesondere zur Binnendifferenzierung geeignet. So können Lernende je nach Lernstand und Hörerfahrung mit verschiedenen Abspielgeschwindigkeiten arbeiten. Zudem ist denkbar, dass Lernende ihrem Kenntnisstand entsprechend entweder die aussprachenahe Fassung eines Transkripts oder die orthografisch normalisierte Version bzw. ggf. auch beide Fassungen vorgelegt bekommen. Zudem lässt sich mit Hilfe der Visualisierung aller orthografisch normalisierten Einheiten sowie der Sprechgeschwindigkeit die Aufmerksamkeit der Lernenden auf Phänomene der gesprochenen Sprache lenken und somit die Sprachbewusstheit für diese sprachlichen Besonderheiten fördern.

Auch die Hervorhebung von ausgewählten Einheiten und Phänomenen im Transkript durch eine rote Umrahmung ermöglicht eine gezielte Steuerung der Aufmerksamkeit der Lernenden. Dem Ansatz des focus on form entsprechend (vgl. Long 1991) lassen sich auf diese Weise sprachliche Formen explizit betrachten. Hinzu kommt, dass sie durch das Format des Transkripts stets in ihrer kommunikativen Einbettung und damit nicht losgelöst von konkreten sprachlichen Handlungen akzentuiert werden. Gleichzeitig kann dabei auch Überlegungen der textsortenbezogenen Sprachdidaktik (vgl. Fandrych / Thurmair 2011a und b) entsprochen werden, da sich die jeweils fokussierten Phänomene auch in Zusammenhang mit der jeweiligen Diskursart und Interaktionsdomäne betrachten lassen. Dies bietet für eine Vielzahl von sprachlichen Phänomenen, die innerhalb des Satzrahmens nicht hinreichend erfasst bzw. vermittelt werden können (bspw. Artikelgebrauch, Pronominalisierung), einen erheblichen Mehrwert.

ZuViel eröffnet damit nicht nur umfassende Möglichkeiten zur gezielten Vermittlung von Besonderheiten der gesprochenen Sprache, sondern gestattet darüber hinaus auch Reflexionsprozesse zu Phänomenen, die nicht ausschließlich mit der gesprochenen Sprache assoziiert werden.

4.3 Nutzung von ZuViel in forschungsbezogenen Kontexten

Auch aus Forschungsperspektive bietet ZuViel vielfältige Nutzungsmöglichkeiten. Insbesondere für qualitative Analysen sind die verschiedenen Visualisierungs- und Interaktionsoptionen besonders hilfreich. Einen besonderen Mehrwert bietet die rote Umrahmung der in einer vorangegangenen Query im Tool ZuRecht ermittelten bzw. fokussierten Einheiten bzw. Sequenzen. Diese lassen sich durch die Hervorhebung in ZuViel direkt ansteuern und weiter analysieren. Denkbar wäre hier etwa die Disambiguierung mehrdeutiger Formen oder auch das Aussortieren von falsch positiven Treffern, was häufig einen Rückgriff auf die vorhandenen Annotationen einerseits und auf einen größeren Transkriptkontext und/oder auf das zugrunde liegende Audio oder Video andererseits erfordert. Werden Transkripte in ZuRecht über die Suche mit Wortschatz- oder Querylisten ermittelt, ermöglicht die Markierung der gesuchten Lemmata bzw. Sequenzen zudem einen Überblick über deren Verteilung im gesamten Sprechereignis.

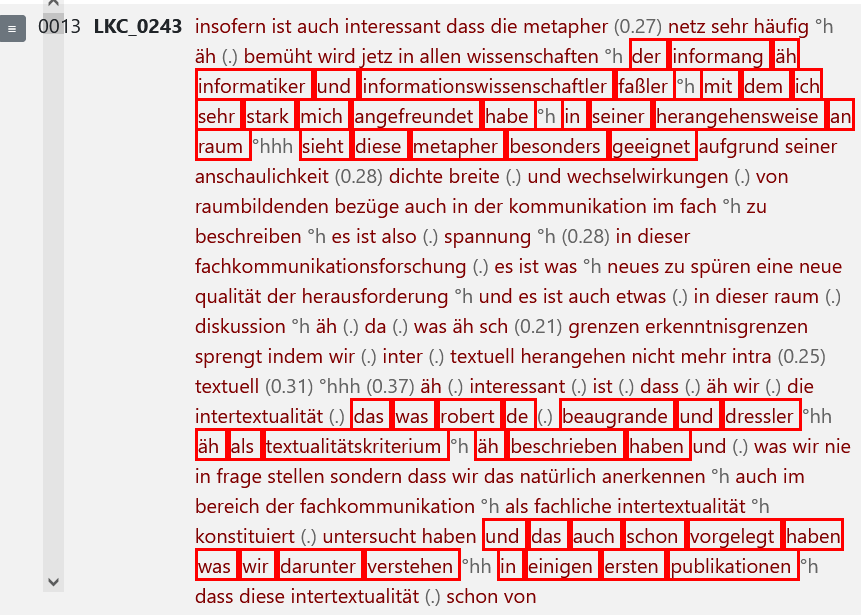

Abbildung 16 zeigt dies am Beispiel von mündlichen Zitat- und Verweisrealisierungen innerhalb eines Expertenvortrags. Mit Hilfe der Suche mit einer Queryliste wurde vorab in ZuRecht nach Vorträgen gesucht, die besonders viele Vorkommen von Zitaten und Verweisen aufweisen.

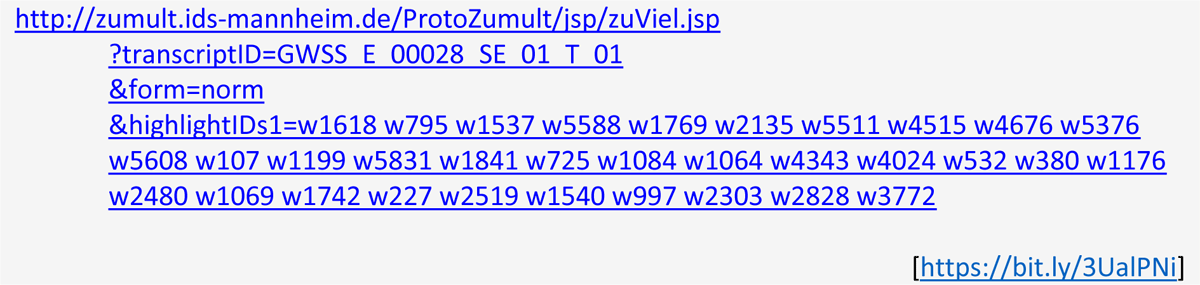

Der Aufruf eines Sprechereignisses in ZuViel mit gleichzeitiger Markierung ausgewählter Formen oder Sequenzen ist auch über Beleg-URLs möglich. Diese werden beim Download von Ergebnissen der Konkordanzsuche in ZuRecht zur Verfügung gestellt. Im weiteren Forschungsprozess können die heruntergeladenen Konkordanzen in Excel bereinigt und mit weiteren Kodierungen und Annotationen versehen werden (vgl. hierzu auch den Beitrag von Frick / Helmer / Wallner 2023 in dieser Themenausgabe). Mit Hilfe der für jede Belegstelle bereitgestellten Beleg-URL lassen sich die einzelnen Belege wiederum in ZuViel aufrufen. Somit können die Ergebnisse eigener Kodierungen und Annotationen für die Forschercommunity zugänglich gemacht werden. Ein Beispiel dafür sind argumentative Positionierungskonstruktionen, die in den Expertenvorträgen des GeWiss-Korpus ermittelt wurden (vgl. Fandrych / Wallner 2023). Die Links zu den dabei als Positionierung eingestuften Belegstellen können über ‚zumult.org‘ abgerufen und für weitere Analysen genutzt werden. Forschungsergebnisse werden damit auch langfristig überprüf- und nachnutzbar. Zudem lassen sich auf der Grundlage der Beleg-URLs auch sogenannte Sammel-URLs erstellen, die es ermöglichen, alle ermittelten Belegstellen (in diesem Fall für Positionierungskonstruktionen) innerhalb eines Vortrags auf einmal in ZuViel aufzurufen und durch eine Umrahmung hervorzuheben. Die folgende Beleg-URL führt bspw. zu einem Expertenvortrag aus dem GeWiss-Korpus, indem insgesamt 33 Positionierungen identifiziert wurden.

Rot umrahmt sind in der in ZuViel angezeigten Transkriptansicht die Indikatorlemmata, mit deren Hilfe in der vorab durchgeführten Konkordanzsuche in ZuRecht potenzielle Belegstellen ermittelt wurden (vgl. Fandrych / Wallner 2023).

Diese Form der Dokumentation und Bereitstellung von Forschungsergebnissen fördert zum einen Möglichkeiten zur dezentralen Zusammenarbeit. Zum anderen werden Forschungsergebnisse auf diese Weise besser überprüfbar und können zur Beantwortung weiterführender Fragestellungen nachgenutzt werden.

5. Fazit / Ausblick

Mit ZuViel wurde ein vielseitiges Werkzeug für eine integrierte Darstellung von Transkripten und zugrunde liegenden Audio-/Videoaufnahmen entwickelt, das es Nutzer:innen ermöglicht, die Visualisierung flexibel eigenen Bedürfnissen anzupassen und über verschiedene Zugriffsinstrumente gezielt Stellen in den Daten anzusteuern. Die implementierten Visualisierungsoptionen orientierten sich dabei an sprachdidaktischen und forschungsbezogenen Nutzungsbedürfnissen.

ZuViel zeigt, wie ein niedrigschwelliger und an spezifischen Nutzungsbedürfnissen ausgerichteter Zugang zu Transkripten aussehen kann. Natürlich konnten im Rahmen des Projekts bei weitem nicht alle potenziellen Bedürfnisse gleichermaßen aufgegriffen werden. Viele neue Anforderungen oder Ideen entstehen zudem gerade erst durch die neuen Zugangsmöglichkeiten, die ZuViel bereitstellt. Da das Tool – wie in der Einleitung beschrieben – auf der ZuMult-Architektur aufbaut, die eine flexible Anpassung und Erweiterung ermöglicht, wird ZuViel selbst in Zukunft mit Blick auf diese Bedürfnisse weiterentwickelt werden. Zudem sollte auch eine Übertragung ausgewählter Komponenten (und ggf. die Entwicklung weiterer Visualisierungselemente) für andere Typen von Korpora und/oder andere Nutzungsszenarien in Zukunft möglich sein.

Notes

- Die fehlenden Möglichkeiten zur Rekontextualisierung haben in Plattformen für schriftliche Korpora aber auch oft praktische Gründe, wenn z.B. die betreffenden Vereinbarungen mit Textlieferanten (Verlage u.Ä.) eine Maximalgröße für zugängliche Textausschnitte beinhalten. [^]

- Nach den FOLK-Normalisierungskonventionen (vgl. Winterscheid et al. 2019) werden auch Formen wie irgendwas (Zeile 0034) und was (Zeile 0037) zu irgendetwas bzw. etwas normalisiert und erscheinen daher in dieser Darstellung unterstrichelt. [^]

- Bei einer Query-Liste handelt es sich um eine txt-Datei, in der Suchanfragen formuliert werden. Die Suchanfrage (<VZ/>) ermöglicht beispielsweise eine Suche nach allen Sprechereignissen, in denen Verweise und Zitate annotiert wurden. Je nach Einstellung der Sortierung werden die so ermittelten Sprechereignisse geordnet nach der absoluten oder relativen Vorkommenshäufigkeit von Verweisen und Zitaten aufgelistet und können von ZuRecht aus in ZuViel aufgerufen werden. [^]

Literatur und Ressourcen

Amorocho, Simone / Pfeiffer, Christian (im Druck): Konstruktionsdidaktik – Grundzüge einer sprachdidaktischen Konzeption. In: Deutsch als Fremdsprache 60: 3.

Boersma, Paul (2001): Praat, a system for doing phonetics by computer. In: Glot International 5: 9/10, 341–345.

Boulton, Alex (2009): Data-driven learning: Reasonable fears and rational reassurance. In: Indian Journal of Applied Linguistics 35: 1, 81–106.

Dietz, Gunther (2021): Korpora gesprochener Sprache als Quelle für die Erstellung von Mikro-Hörübungen mit authentischen Hörmaterialien im DaZ-/DaF-Unterricht. In: KorDaF – Korpora Deutsch als Fremdsprache 1: 1, 97–123.

Fandrych, Christian / Meißner, Cordula / Schwendemann, Matthias / Wallner, Franziska (2023): ZuMal: Zielgruppenspezifische Gesprächsauswahl aus Korpora gesprochener Sprache. In: Korpora Deutsch als Fremdsprache 3: 1, 13–43.

Fandrych, Christian / Meißner, Cordula / Wallner, Franziska (Hrsg.) (2017): Gesprochene Wissenschaftssprache – digital. Verfahren zur Annotation und Analyse mündlicher Korpora. Tübingen: Stauffenburg.

Fandrych, Christian / Schwendemann, Matthias / Wallner, Franziska (2021): „Ich brauch da dringend ein passendes Beispiel …“: Sprachdidaktisch orientierte Zugriffsmöglichkeiten auf Korpora der gesprochenen Sprache aus dem Projekt ZuMult. In: Informationen Deutsch als Fremdsprache 48: 6, 711–729.

Fandrych, Christian / Thurmair, Maria (2011a): Textsorten im Deutschen: Linguistische Analysen aus sprachdidaktischer Sicht. Tübingen: Stauffenburg.

Fandrych, Christian / Thurmair, Maria (2011b): Plädoyer für eine textsortenbezogene Sprachdidaktik. In: Deutsch als Fremdsprache 48: 2, 84–93.

Fandrych, Christian / Wallner, Franziska (2023): Das GeWiss-Korpus: Neue Forschungs- und Vermittlungsperspektiven zur mündlichen Hochschulkommunikation. In: Deppermann, Arnulf / Fandrych, Christian / Kupietz, Marc / Schmidt, Thomas (Hrsg): Korpora in der germanistischen Sprachwissenschaft: Mündlich, schriftlich, multimedial. Berlin / Boston: De Gruyter, 129–160.

Frick, Elena / Helmer, Henrike / Wallner, Franziska (2023): ZuRecht: Neue Recherchemöglichkeiten in Korpora gesprochener Sprache für Gesprächsanalyse und Deutsch als Fremd- und Zweitsprache. In: Korpora Deutsch als Fremdsprache 3: 1, 44–72.

Günthner, Susanne / Wegner, Lars / Weidner, Beate (2013): Gesprochene Sprache im DaF-Unterricht – Möglichkeit der Vernetzung der Gesprochene-Sprache-Forschung mit der Fremdsprachenvermittlung. In: Moraldo, Sandro / Missaglia, Federica (Hrsg.): Gesprochene Sprache im DaF-Unterricht. Grundlagen –Ansätze – Praxis. Heidelberg: Winter, 113–150.

Imo, Wolfgang / Weidner, Beate (2018): Mündliche Korpora im DaF- und DaZ-Unterricht. In: Schmidt, Thomas / Kupietz, Marc (Hrsg.): Korpora in der Linguistik. Berlin / Boston: De Gruyter, 231–251.

Kaiser, Julia (2023): ZuHand: Zugang zu Handlungssequenzen und handlungsbezogenen Themenausschnitten in einem qualitativ annotierten FOLK-Subkorpus. In: Korpora Deutsch als Fremdsprache 3: 1, 92–111.

Long, Michael (1991): Focus on form: A design feature in language teaching methodology. In: De Bot, Kees / Ginsberg, Ralph / Kramsch, Claire (Hrsg.): Foreign language research in cross-cultural perspectives. Amsterdam: John Benjamins, 39–52.

Meißner, Cordula / Wallner, Franziska (2022): Korpora gesprochener Sprache als virtuelle Lernräume der Mündlichkeitsdidaktik: Affordanzen eines außerunterrichtlichen Sprachlernsettings. In: Feick, Diana / Rymarczyk, Jutta (Hrsg.): Zur Digitalisierung von Lernorten – Fremdsprachenlernen im virtuellen Raum. Tagungsband zum 28. DGFF-Kongress an der Julius-Maximilians-Universität Würzburg 2019, 215–239.

Moraldo, Sandro / Missaglia, Federica (Hrsg.) (2013): Gesprochene Sprache im DaF-Unterricht. Grundlagen –Ansätze – Praxis. Heidelberg: Winter.

Schmidt, Thomas (2005): Computergestützte Transkription – Modellierung und Visualisierung gesprochener Sprache mit texttechnologischen Mitteln. (= Sprache, Sprechen und Computer 7). Frankfurt am Main et al.: Lang.

Schmidt, Thomas (2010): Another Extension of the Stylesheet Metaphor. In: Witt, Andreas / Metzing, Dieter (Hrsg.): Linguistic Modeling of Information and Markup Languages. Contributions to Language Technology. (= Text, Speech and Language Technology 41). Dordrecht: Springer, 23–44.

Schmidt, Thomas / Fandrych, Christian / Frick, Elena / Schwendemann, Matthias / Wallner, Franziska / Wörner, Kai (2023): Zugänge zu mündlichen Korpora für DaF und DaZ. Projekt, Datengrundlagen, technische Basis. In: Korpora Deutsch als Fremdsprache 3: 1, 1–12.

Schmidt, Thomas / Wörner, Kai (2014): EXMARaLDA. In: Durand, Jacques / Gut, Ulrike / Kristoffersen, Gjert (Hrsg.): The Oxford Handbook on Corpus Phonology. Oxford: Oxford University Press, 402–419.

Sloetjes, Han (2014): ELAN: Multimedia annotation application. In: Durand, Jacques / U. Gut, Ulrike / Kristoffersen, Gjert (Hrsg.): The Oxford Handbook of Corpus Phonology. Oxford: Oxford University Press, 305–310.

Westpfahl, Swantje (2020): POS-Tagging für Transkripte gesprochener Sprache. Entwicklung einer automatisierten Wortarten-Annotation am Beispiel des Forschungs- und Lehrkorpus Gesprochenes Deutsch (FOLK). Studien zur deutschen Sprache (83). Tübingen: Narr.

Winterscheid, Jenny / Deppermann, Arnulf / Schmidt, Thomas / Schütte, Wilfried / Schedl, Evi / Kaiser, Julia (2019): Normalisieren mit OrthoNormal. Konventionen und Bedienungshinweise für die orthografische Normalisierung von FOLKER-Transkripten. http://doi.org/10.14618/ids-pub-9326.

Biographische Notiz:

Thomas Schmidt ist Software-Entwickler bei Musical Bits GmbH und linguisticbits.de. Er hat bis 2021 den Programmbereich „Mündliche Korpora“ und das Archiv für Gesprochenes Deutsch am Leibniz-Institut für Deutsche Sprache in Mannheim geleitet. Seine Forschungsinteressen liegen in der Korpuslinguistik und Korpustechnologie für mündliche Korpora sowie in der digitalen Lexikographie.

Kontaktanschrift:

Thomas Schmidt

Musical Bits GmbH

Nahestraße 28

55411 Bingen

Deutschland

Biographische Notiz:

Matthias Schwendemann ist wissenschaftlicher Mitarbeiter im Bereich Linguistik am Herder-Institut der Universität Leipzig. Seine Arbeitsschwerpunkte in Forschung und Lehre liegen in den Bereichen Lexikologie, Wissenschaftssprache und Erwerb und Entwicklung des Deutschen als Fremd- und Zweitsprache sowie der Analyse von Lernersprache.

Kontaktanschrift:

Matthias Schwendemann

Herder-Institut der Universität Leipzig

Beethovenstr. 15

04107 Leipzig

Deutschland

Biographische Notiz:

Franziska Wallner ist wissenschaftliche Mitarbeiterin im Bereich Linguistik am Herder-Institut der Universität Leipzig. Ihre Forschungsschwerpunkte sind unter anderen das Deutsche als fremde Bildungs- und Wissenschaftssprache, die korpusbasierte Erforschung der gesprochenen Sprache, Mündlichkeitsdidaktik sowie die Nutzung von Korpora im Kontext von Deutsch als Fremd- und Zweitsprache.

Kontaktanschrift:

Franziska Wallner

Herder-Institut der Universität Leipzig

Beethovenstr. 15

04107 Leipzig

Deutschland